ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

Nếu bạn thấy dự án này hữu ích,

hãy tặng một sao ⭐ trên GitHub để ủng hộ!

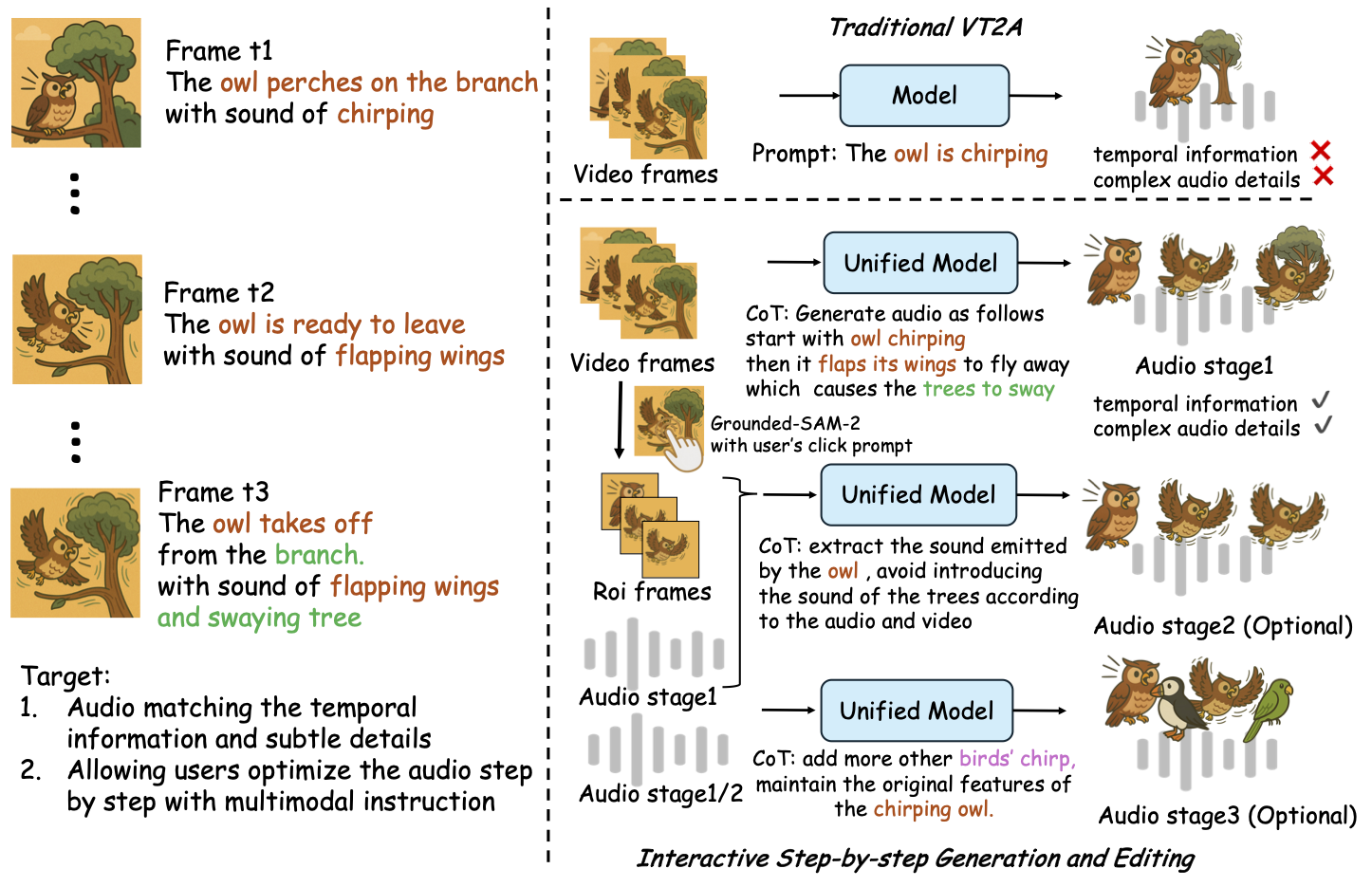

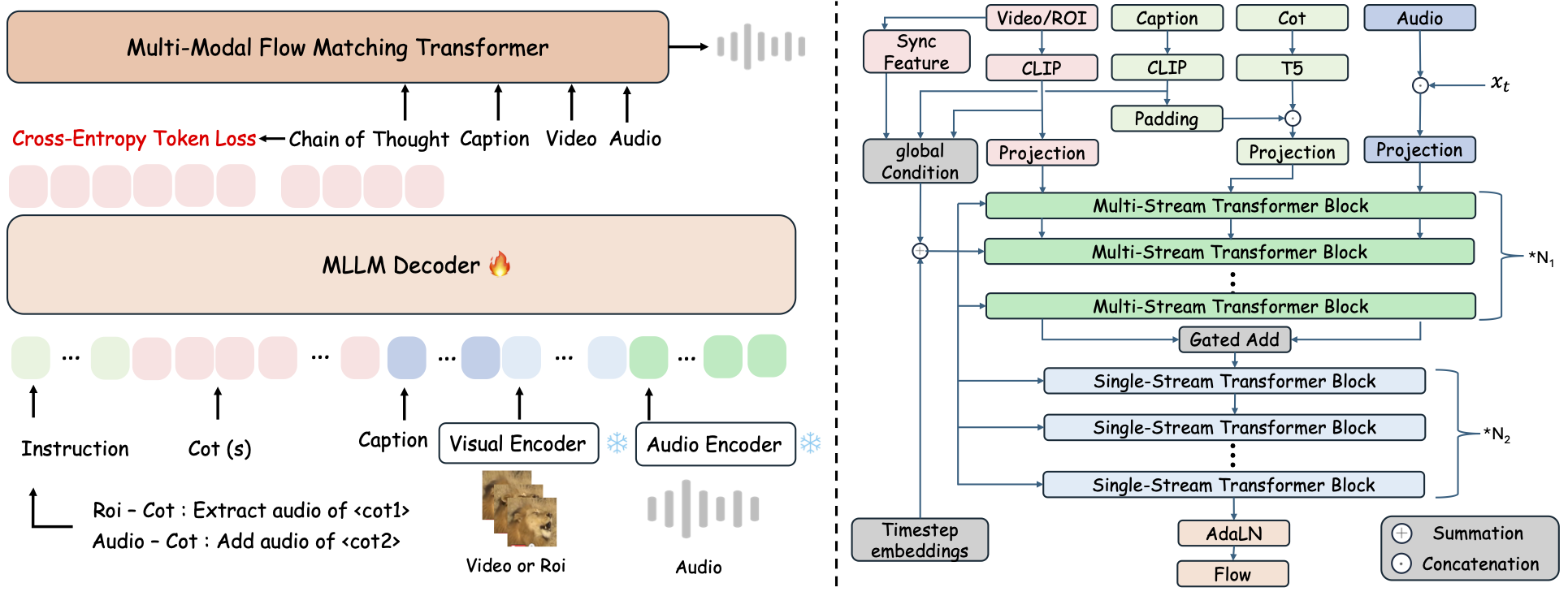

ThinkSound là một khung tạo Any2Audio thống nhất với phương pháp ghép luồng được hướng dẫn bởi lý luận Chuỗi-Suy-Nghĩ (CoT).

Triển khai PyTorch cho tạo và chỉnh sửa âm thanh đa phương thức: tạo hoặc chỉnh sửa âm thanh từ video, văn bản và âm thanh, được hỗ trợ bởi suy luận từng bước từ các Mô hình Ngôn ngữ Lớn Đa phương thức (MLLMs).

📰 Tin tức

- 2025.11.25 🔥Demo PrismAudio trực tuyến đã ra mắt - hãy thử ngay!

- 2025.11.25 🔥Bài báo PrismAudio được phát hành trên arXiv, là khuôn khổ CoT-RL đa chiều đầu tiên cho Tạo âm thanh từ Video!

- 2025.09.19 🎉 ThinkSound đã được chấp nhận vào Hội nghị NeurIPS 2025!

- 2025.09.01 Bộ dữ liệu AudioCoT của chúng tôi hiện đã mã nguồn mở và có sẵn trên Hugging Face!

- 2025.07.17 🧠 Đã hỗ trợ tinh chỉnh: mã huấn luyện và tinh chỉnh hiện đã được công khai, kèm hướng dẫn sử dụng rõ ràng giúp bạn tùy chỉnh và mở rộng ThinkSound với dữ liệu của riêng mình.

- 2025.07.15 📦 Đơn giản hóa cài đặt và sử dụng: các phụ thuộc trên PyPI giúp thiết lập đa nền tảng dễ dàng; script

.batcho Windows tự động tạo môi trường và chạy script. - 2025.07.08 🔧 Cập nhật lớn: tối ưu hóa bộ nhớ và GPU, giảm nhẹ mô hình, nay hỗ trợ tạo âm thanh tốc độ cao ở quy mô lớn!

- 2025.07.01 Demo trực tuyến trên Hugging Face Spaces và ModelScope cho trải nghiệm tương tác!

- 2025.07.01 Đã phát hành script suy luận và giao diện web;

- 2025.06 Bài báo ThinkSound được công bố trên arXiv!

- 2025.06 Demo trực tuyến đã ra mắt - hãy thử ngay!

🚀 Tính năng

- Any2Audio: Tạo âm thanh từ bất kỳ phương thức nào — video, văn bản, âm thanh hoặc kết hợp các phương thức.

- Video-to-Audio SOTA: Đạt kết quả tốt nhất trên nhiều benchmark V2A.

- Suy luận CoT: Suy luận Chuỗi Tư duy cho tạo âm thanh có tính thành phần và kiểm soát thông qua MLLMs.

- Chỉnh sửa tập trung đối tượng tương tác: Tinh chỉnh hoặc chỉnh sửa sự kiện âm thanh cụ thể bằng cách nhấp vào đối tượng trực quan hoặc sử dụng hướng dẫn văn bản.

- Khung thống nhất: Một mô hình nền tảng hỗ trợ tạo, chỉnh sửa và quy trình tương tác.

✨ Tổng quan phương pháp

ThinkSound phân tách quá trình tạo và chỉnh sửa âm thanh thành ba giai đoạn tương tác, tất cả đều được hướng dẫn bởi suy luận Chuỗi Tư duy (CoT) dựa trên MLLM:

- Tạo Foley: Tạo cảnh âm thanh nền, căn chỉnh ngữ nghĩa và thời gian từ video.

- Tinh chỉnh tập trung đối tượng: Tinh chỉnh hoặc thêm âm thanh cho các đối tượng do người dùng chỉ định qua nhấp chuột hoặc vùng trong video.

- Chỉnh sửa âm thanh có mục tiêu: Sửa đổi âm thanh đã tạo bằng hướng dẫn ngôn ngữ tự nhiên cấp cao.

⚡ Bắt đầu nhanh

Chuẩn bị môi trường:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ Mẹo cho Windows:

Người dùng Windows chỉ cần chạy setup_windows.bat (hoặc nhấp đúp vào nó) để tự động tạo môi trường conda, cài đặt tất cả các phụ thuộc (bao gồm cả FFmpeg), và tải về mô hình đã huấn luyện — không cần thiết lập thủ công.

Hãy đảm bảo rằngcondavàgitđã được cài đặt và có trong PATH hệ thống của bạn trước khi chạy script.

▶️ Chạy Demo

#### Linux/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Bạn có thể sử dụng tập lệnh <code>.bat</code> được cung cấp thay thế:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>Lưu ý:</strong></p><ul><li><code><path-to-your-demo-video></code>: Đường dẫn đến một video duy nhất</li>

<li><code>[use-half]</code> (tùy chọn): Thêm use-half vào cuối để bật chức năng trích xuất đặc tả với độ chính xác nửa.</li></p><p></ul>---</p><h3>📦 Suy luận theo lô</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Sử dụng script <code>.bat</code> tương đương:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>Lưu ý:</strong></p><ul><li><code><video_path></code>: Đường dẫn đến thư mục gốc chứa tất cả các video .mp4 cần xử lý (tất cả video phải có cùng độ dài).</li>

<li><code><csv_path></code>: Một tệp CSV chứa các lệnh văn bản cho mỗi video (xem <code>demo_test.csv</code> để biết định dạng).</li>

<li><code><save_path></code> (tùy chọn): Nơi lưu trữ tệp âm thanh được tạo ra. Mặc định là <code>results/features</code>.</li>

<li><code>[use-half]</code> (tùy chọn): Thêm use-half ở cuối để bật tính năng trích xuất đặc trưng với độ chính xác nửa.</li></p><p></ul>---</p><h3>Sử Dụng Giao Diện Web</h3></p><p>Để trải nghiệm tương tác, hãy khởi chạy giao diện web Gradio:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ Huấn Luyện Mô Hình</h2></p><p>Xem <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 VIỆC CẦN LÀM & Kế Hoạch Tương Lai</h2>

<ul><li>- [ ] Phát hành mô hình nền tảng mạnh mẽ hơn, bao phủ nhiều lĩnh vực để cung cấp trải nghiệm tạo foley hấp dẫn và sống động hơn</li>

<li>- [ ] Thêm hỗ trợ cho các dạng dữ liệu và tác vụ hạ nguồn bổ sung</li>

<li>- [ ] Phát hành các mô hình ở các quy mô khác nhau</li>

<li>- [x] Mã nguồn mở bộ dữ liệu AudioCoT và quy trình tự động</li>

<li>- [x] Phát hành các script huấn luyện cho các mô hình ThinkSound</li>

<li>- [x] README hướng dẫn nhanh cho người mới dùng Windows</li>

</ul>---</p><h2>📄 Giấy Phép</h2></p><p>Dự án này được phát hành theo Giấy phép Apache 2.0.</p><blockquote><strong>Lưu ý:</strong></blockquote>

<blockquote>Mã nguồn, mô hình và bộ dữ liệu <strong>chỉ dành cho mục đích nghiên cứu và giáo dục</strong>.</blockquote>

<blockquote><strong>Không được phép sử dụng cho mục đích thương mại.</strong></blockquote>

<blockquote>Để xin giấy phép thương mại, vui lòng liên hệ tác giả.</blockquote></p><p><strong>📦 Thành Phần Bên Thứ Ba</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (bởi Stability AI):</li>

</ul>Kho lưu trữ này bao gồm một VAE đã tinh chỉnh từ <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a>, được cấp phép theo <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">Stability AI Community License</a>.

<strong>Việc sử dụng thương mại và phân phối lại cần có sự cho phép trước của Stability AI.</strong></p><ul><li>📘 <strong>Tất cả mã nguồn và mô hình còn lại</strong> được phát hành theo Giấy phép Apache 2.0.</li></p><p></ul>---</p><h2>Lời cảm ơn</h2></p><p>Xin cảm ơn đến:</p><ul><li><strong>stable-audio-tools</strong> (bởi Stability AI):</li>

</ul>Đã cung cấp một khung dễ sử dụng cho việc sinh âm thanh, cũng như module VAE và trọng số.

<ul><li><strong>MMAudio</strong>:</li>

</ul>Đã triển khai backbone MM-DiT trong lĩnh vực âm thanh.</p><hr></p><h2>📖 Trích dẫn</h2></p><p>Nếu bạn thấy ThinkSound hữu ích trong nghiên cứu hoặc công việc của mình, vui lòng trích dẫn bài báo của chúng tôi:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>