ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

Eğer bu projeyi faydalı bulduysanız,

GitHub'da bir yıldız ⭐ bırakmanız çok memnuniyet verici olur!

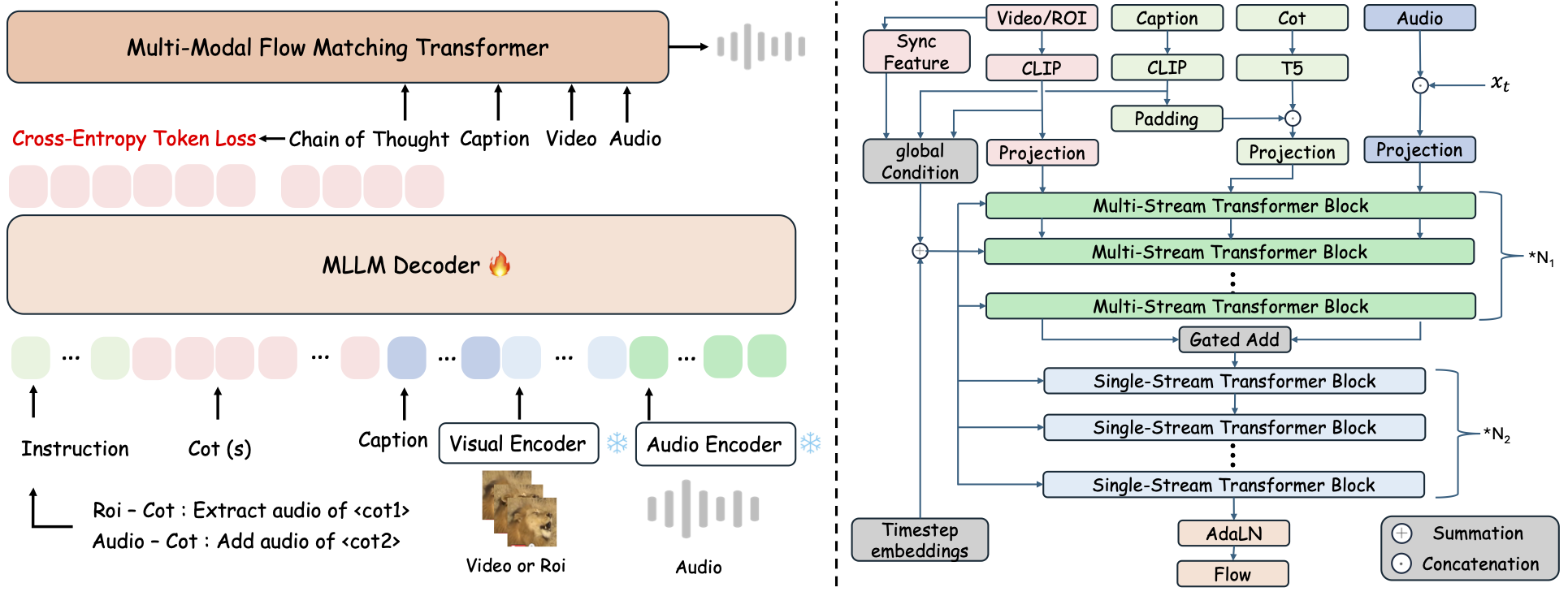

ThinkSound, Zincirleme-Düşünce (CoT) çıkarımıyla yönlendirilen akış eşleştirmesine sahip, birleşik bir Any2Audio üretim çerçevesidir.

Multimodal ses üretimi ve düzenlemesi için PyTorch uygulaması: Video, metin ve sesten ses üretin veya düzenleyin; Multimodal Büyük Dil Modellerinin (MLLM'ler) adım adım akıl yürütmesiyle desteklenmektedir.

📰 Haberler

- 2025.11.25 🔥Online PrismAudio Demo yayında - hemen deneyin!

- 2025.11.25 🔥PrismAudio makalesi arXiv'de yayınlandı, Video'dan Sese Üretim için ilk çok boyutlu CoT-RL çerçevesi!

- 2025.09.19 🎉 ThinkSound NeurIPS 2025 Ana Konferansı'na kabul edildi!

- 2025.09.01 AudioCoT veri setimiz artık açık kaynaklı ve Hugging Face'te mevcut!

- 2025.07.17 🧠 İnce ayar etkin: eğitim ve ince ayar kodları artık herkese açık, ThinkSound'u kendi verilerinizle özelleştirmeniz ve genişletmeniz için açık talimatlar içeriyor.

- 2025.07.15 📦 Kolay kurulum ve kullanılabilirlik: PyPI'deki bağımlılıklar sayesinde platformlar arası kolay kurulum; Windows

.batbetikleri ortam oluşturma ve betik çalıştırmayı otomatikleştirir. - 2025.07.08 🔧 Büyük güncelleme: model hafifletildi ve bellek ile GPU kullanımı optimize edildi, artık ölçeklenebilir yüksek verimli ses üretimi destekleniyor!

- 2025.07.01 Hugging Face Spaces ve ModelScope üzerinde çevrimiçi demo, etkileşimli deneyim için!

- 2025.07.01 Çıkarım betikleri ve web arayüzü yayınlandı;

- 2025.06 ThinkSound makalesi arXiv'de yayınlandı!

- 2025.06 Çevrimiçi Demo yayında - hemen deneyin!

🚀 Özellikler

- Any2Audio: Rastgele modlardan — video, metin, ses veya bunların kombinasyonlarından — ses üretimi.

- Video'dan Sese SOTA: Birçok V2A benchmark'ında son teknoloji sonuçlar elde eder.

- CoT Destekli Akıl Yürütme: MLLM'ler aracılığıyla bileşen tabanlı ve kontrol edilebilir ses üretimi için Düşünce Zinciri akıl yürütmesi.

- Etkileşimli Nesne Merkezli Düzenleme: Görsel nesnelere tıklayarak veya metin talimatları kullanarak belirli ses olaylarını düzenleyin veya iyileştirin.

- Birleşik Çerçeve: Tek bir temel model üretim, düzenleme ve etkileşimli iş akışını destekler.

✨ Yöntem Genel Bakış

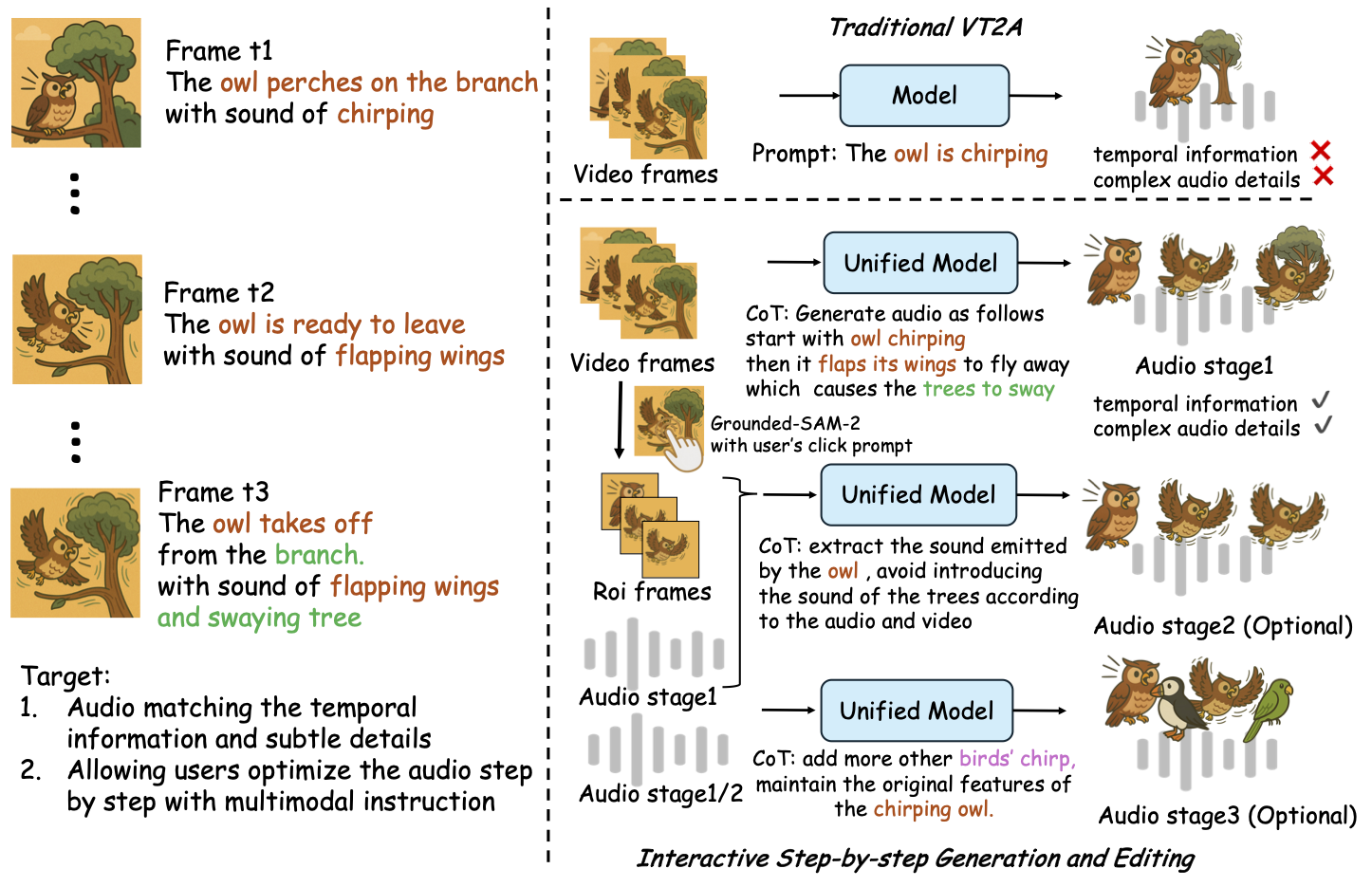

ThinkSound, ses üretimi ve düzenleme işini MLLM tabanlı Düşünce Zinciri (CoT) akıl yürütmesiyle yönlendirilen üç etkileşimli aşamaya ayırır:

- Foley Üretimi: Videodan anlamsal ve zamansal olarak hizalanmış temel ses ortamları oluşturun.

- Nesne Merkezli İyileştirme: Videoda tıklamalar veya bölgeler aracılığıyla kullanıcı tarafından belirtilen nesneler için sesleri iyileştirin veya ekleyin.

- Hedefe Yönelik Ses Düzenleme: Üretilen sesi üst düzey doğal dil talimatlarıyla değiştirin.

⚡ Hızlı Başlangıç

Ortam Hazırlığı:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ Windows İpucu:

Windows kullanıcıları, setup_windows.bat dosyasını çalıştırarak (veya çift tıklayarak) conda ortamını otomatik olarak oluşturabilir, tüm bağımlılıkları (FFmpeg dahil) yükleyebilir ve önceden eğitilmiş modeli indirebilir — elle kurulum gerekmez.

Scripti çalıştırmadan önce,condavegit'in sistem PATH'inizde kurulu ve erişilebilir olduğundan emin olun.

▶️ Demoyu Çalıştırın

#### Linux/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Bunun yerine sağlanan <code>.bat</code> betiğini kullanabilirsiniz:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>Not:</strong></p><ul><li><code><path-to-your-demo-video></code>: Tek bir videonun yolu</li>

<li><code>[use-half]</code> (isteğe bağlı): Yarı hassasiyetli özellik çıkarımını etkinleştirmek için sona use-half ekleyin.</li></p><p></ul>---</p><h3>📦 Toplu Çıkarım</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Eşdeğer <code>.bat</code> betiğini kullanın:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>Not:</strong></p><ul><li><code><video_path></code>: İşlenecek tüm .mp4 videoların bulunduğu kök dizinin yolu (tüm videolar aynı sürede olmalıdır).</li>

<li><code><csv_path></code>: Her video için metin istemleri içeren bir CSV dosyası (<code>demo_test.csv</code> formatına bakınız).</li>

<li><code><save_path></code> (isteğe bağlı): Oluşturulan sesin kaydedileceği yer. Varsayılan olarak <code>results/features</code>.</li>

<li><code>[use-half]</code> (isteğe bağlı): Yarı hassasiyetli özellik çıkarımını etkinleştirmek için en sona use-half ekleyin.</li></p><p></ul>---</p><h3>Web Arayüzü Kullanımı</h3></p><p>Etkileşimli bir deneyim için Gradio web arayüzünü başlatın:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ Modeli Eğitme</h2></p><p>Bakınız <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 TODO & Gelecek Planları</h2>

<ul><li>- [ ] Daha güçlü, çoklu alanları kapsayan bir temel model yayınlanarak daha ilgi çekici ve sürükleyici foley üretimi sağlanacak</li>

<li>- [ ] Ek modlar ve aşağı akış görevleri için destek eklenecek</li>

<li>- [ ] Farklı ölçeklerde modeller yayınlanacak</li>

<li>- [x] AudioCoT veri seti ve otomatikleştirilmiş boru hattı açık kaynak yapılacak</li>

<li>- [x] ThinkSound modelleri için eğitim betikleri yayınlanacak</li>

<li>- [x] Yeni başlayanlar için Windows hızlı başlangıç README'si hazırlanacak</li>

</ul>---</p><h2>📄 Lisans</h2></p><p>Bu proje Apache 2.0 Lisansı altında yayınlanmıştır.</p><blockquote><strong>Not:</strong></blockquote>

<blockquote>Kod, modeller ve veri seti <strong>sadece araştırma ve eğitim amaçlıdır</strong>.</blockquote>

<blockquote><strong>Ticari kullanımına İZİN VERİLMEMEKTEDİR.</strong></blockquote>

<blockquote>Ticari lisanslama için lütfen yazarlarla iletişime geçiniz.</blockquote></p><p><strong>📦 Üçüncü Taraf Bileşenler</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (Stability AI tarafından):</li>

</ul>Bu depo, <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a> adresinden ince ayarlanmış bir VAE içerir ve <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">Stability AI Topluluk Lisansı</a> ile lisanslanmıştır.

<strong>Ticari kullanım ve yeniden dağıtım için Stability AI'den önceden izin alınması gerekmektedir.</strong></p><ul><li>📘 <strong>Diğer tüm kod ve modeller</strong> Apache License 2.0 kapsamında yayınlanmıştır.</li></p><p></ul>---</p><h2>Teşekkürler</h2></p><p>

Çok teşekkürler:</p><ul><li><strong>stable-audio-tools</strong> (Stability AI tarafından):</li>

</ul>Ses üretimi için kolay kullanılabilir bir çerçeve sağladığı, ayrıca VAE modülünü ve ağırlıklarını sunduğu için.

<ul><li><strong>MMAudio</strong>:</li>

</ul>Ses alanında MM-DiT omurgasının uygulanması için.</p><hr></p><h2>📖 Atıf</h2></p><p>ThinkSound'u araştırmanızda veya çalışmalarınızda faydalı bulursanız, lütfen makalemize atıfta bulunun:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>