ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

Если вы считаете этот проект полезным,

звезда ⭐ на GitHub будет очень признательна!

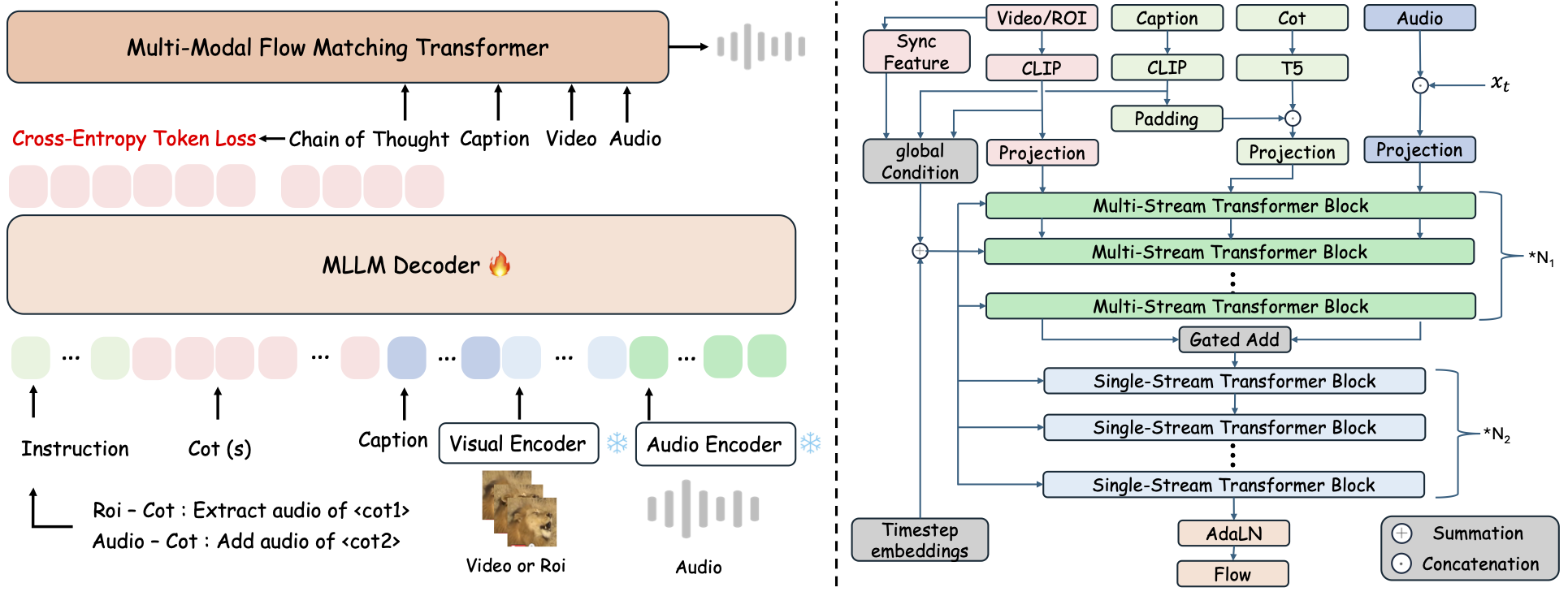

ThinkSound — это унифицированная платформа генерации Any2Audio с сопоставлением потоков, управляемая рассуждениями в стиле Chain-of-Thought (CoT).

Реализация на PyTorch для многомодального аудиогенерирования и редактирования: создавайте или редактируйте аудио по видео, тексту и аудио, с пошаговым рассуждением на основе Мультимодальных Больших Языковых Моделей (MLLM).

📰 Новости

- 2025.11.25 🔥Онлайн демо PrismAudio доступно — попробуйте сейчас!

- 2025.11.25 🔥Статья о PrismAudio опубликована на arXiv, первая многомерная CoT-RL-архитектура для генерации аудио из видео!

- 2025.09.19 🎉 ThinkSound принят на NeurIPS 2025 Main Conference!

- 2025.09.01 Наш датасет AudioCoT теперь в открытом доступе на Hugging Face!

- 2025.07.17 🧠 Доступна дообучаемость: код для обучения и дообучения открыт, с подробной инструкцией по кастомизации и расширению ThinkSound на ваших данных.

- 2025.07.15 📦 Упрощена установка и использование: зависимости через PyPI для легкой кроссплатформенной установки; Windows

.bat-скрипты автоматизируют создание окружения и запуск. - 2025.07.08 🔧 Крупное обновление: модель облегчена, оптимизировано использование памяти и GPU, поддерживает масштабное высокопроизводительное аудиогенерирование!

- 2025.07.01 Онлайн-демо на Hugging Face Spaces и ModelScope для интерактивной работы!

- 2025.07.01 Выпущены скрипты инференса и веб-интерфейс;

- 2025.06 Статья о ThinkSound опубликована на arXiv!

- 2025.06 Онлайн-демо доступно — попробуйте сейчас!

🚀 Возможности

- Any2Audio: Генерация аудио из любых модальностей — видео, текста, аудио или их комбинаций.

- Video-to-Audio SOTA: Достижение лучших результатов на ряде V2A-бенчмарков.

- CoT-управляемое рассуждение: Пошаговое Chain-of-Thought рассуждение для композиционного и управляемого аудиогенерирования через MLLM.

- Интерактивное объектно-центричное редактирование: Детализируйте или редактируйте конкретные звуковые события по клику на визуальных объектах или текстовым инструкциям.

- Единая архитектура: Одна базовая модель поддерживает генерацию, редактирование и интерактивную работу.

✨ Обзор метода

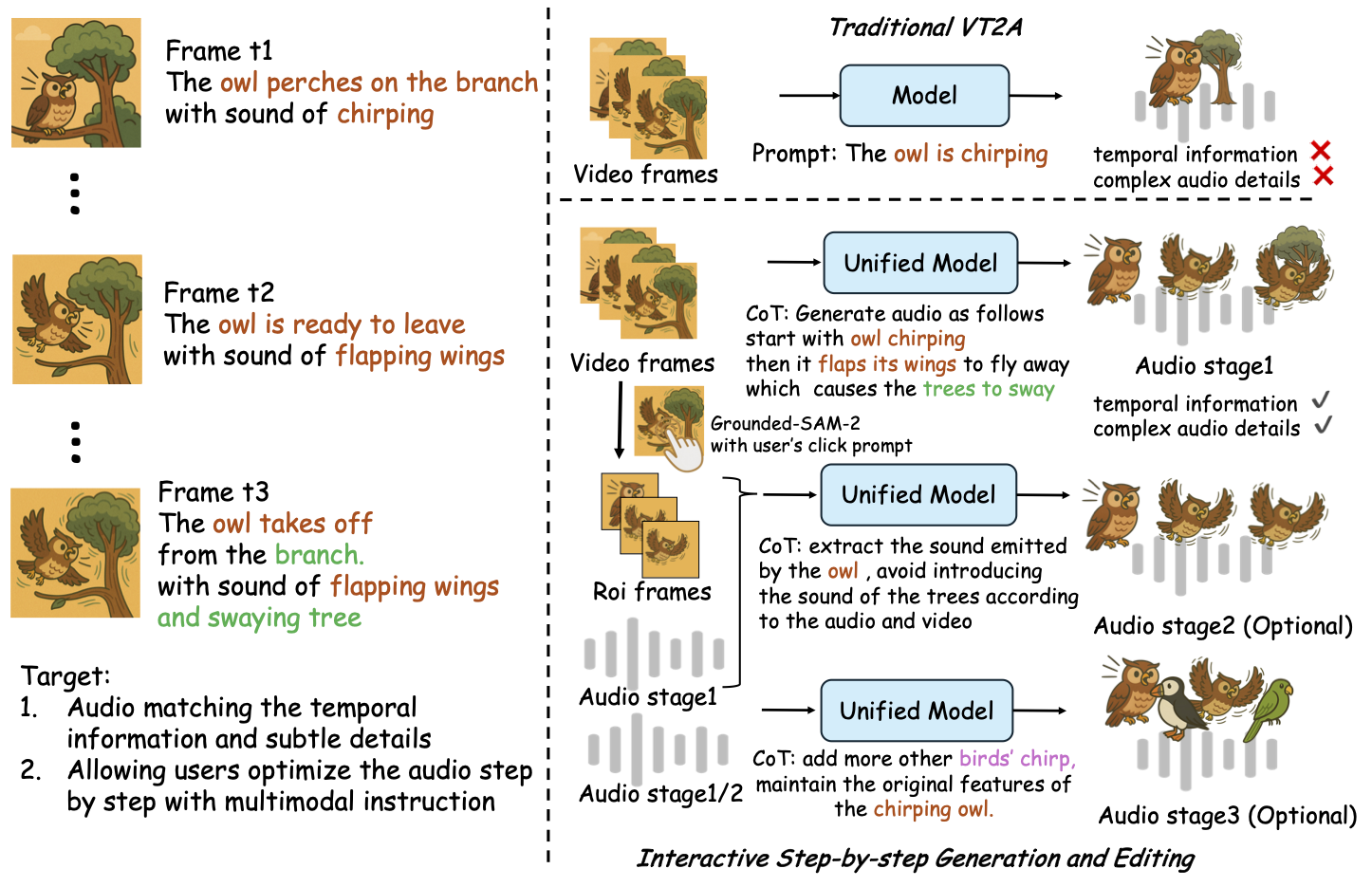

ThinkSound разделяет задачи генерации и редактирования аудио на три интерактивных этапа, все управляются Chain-of-Thought рассуждением на основе MLLM:

- Foley-генерация: Создание базовых, семантически и временно согласованных звуковых ландшафтов по видео.

- Объектно-центричная детализация: Детализация или добавление звуков для выбранных пользователем объектов через клики или области на видео.

- Целевое аудиоредактирование: Модификация сгенерированного аудио с помощью высокоуровневых инструкций на естественном языке.

⚡ Быстрый старт

Подготовка среды:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ Совет для Windows:

Пользователи Windows могут просто запустить setup_windows.bat (или дважды щелкнуть по нему), чтобы автоматически создать среду conda, установить все зависимости (включая FFmpeg) и загрузить предобученную модель — никакой ручной настройки не требуется.

Перед запуском скрипта убедитесь, чтоcondaиgitустановлены и доступны в переменной PATH вашей системы.

▶️ Запуск демо

#### Linux/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Вместо этого вы можете использовать предоставленный скрипт <code>.bat</code>:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>Примечание:</strong></p><ul><li><code><path-to-your-demo-video></code>: Путь к одному видео</li>

<li><code>[use-half]</code> (необязательно): Добавьте use-half в конце для включения извлечения признаков в половинной точности.</li></p><p></ul>---</p><h3>📦 Пакетный вывод</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Используйте эквивалентный скрипт <code>.bat</code>:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>Примечание:</strong></p><ul><li><code><video_path></code>: Путь к корневому каталогу, содержащему все .mp4 видео для обработки (все видео должны быть одинаковой длительности).</li>

<li><code><csv_path></code>: CSV-файл с текстовыми подсказками для каждого видео (см. формат в <code>demo_test.csv</code>).</li>

<li><code><save_path></code> (необязательно): Путь для сохранения сгенерированного аудио. По умолчанию <code>results/features</code>.</li>

<li><code>[use-half]</code> (необязательно): Добавьте use-half в конце для включения извлечения признаков в половинной точности.</li></p><p></ul>---</p><h3>Использование веб-интерфейса</h3></p><p>Для интерактивной работы запустите веб-интерфейс Gradio:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ Обучение модели</h2></p><p>См. <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 Планы TODO и на будущее</h2>

<ul><li>- [ ] Выпустить более мощную базовую модель, охватывающую несколько доменов, для более увлекательного и иммерсивного создания фоли</li>

<li>- [ ] Добавить поддержку дополнительных модальностей и последующих задач</li>

<li>- [ ] Выпустить модели разных масштабов</li>

<li>- [x] Открыть исходный датасет AudioCoT и автоматизированный конвейер</li>

<li>- [x] Выпустить обучающие скрипты для моделей ThinkSound</li>

<li>- [x] README для быстрого старта на Windows для новичков</li>

</ul>---</p><h2>📄 Лицензия</h2></p><p>Этот проект распространяется по лицензии Apache 2.0.</p><blockquote><strong>Примечание:</strong></blockquote>

<blockquote>Код, модели и датасет предназначены <strong>только для научных и образовательных целей</strong>.</blockquote>

<blockquote><strong>Коммерческое использование НЕ разрешено.</strong></blockquote>

<blockquote>Для коммерческого лицензирования, пожалуйста, свяжитесь с авторами.</blockquote></p><p><strong>📦 Сторонние компоненты</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (от Stability AI):</li>

</ul>Этот репозиторий включает доработанный VAE из <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a>, лицензированный по <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">лицензии Stability AI Community License</a>.

<strong>Коммерческое использование и распространение требуют предварительного разрешения Stability AI.</strong></p><ul><li>📘 <strong>Весь остальной код и модели</strong> распространяются по лицензии Apache 2.0.</li></p><p></ul>---</p><h2>Благодарности</h2></p><p>Благодарности:</p><ul><li><strong>stable-audio-tools</strong> (от Stability AI):</li>

</ul>За предоставление удобной платформы для генерации аудио, а также модуля VAE и весов.

<ul><li><strong>MMAudio</strong>:</li>

</ul>За реализацию архитектуры MM-DiT в аудио-домене.</p><hr></p><h2>📖 Цитирование</h2></p><p>Если ThinkSound оказался полезным для ваших исследований или работы, пожалуйста, процитируйте нашу статью:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>