ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

Se você achar este projeto útil,

um star ⭐ no GitHub seria muito apreciado!

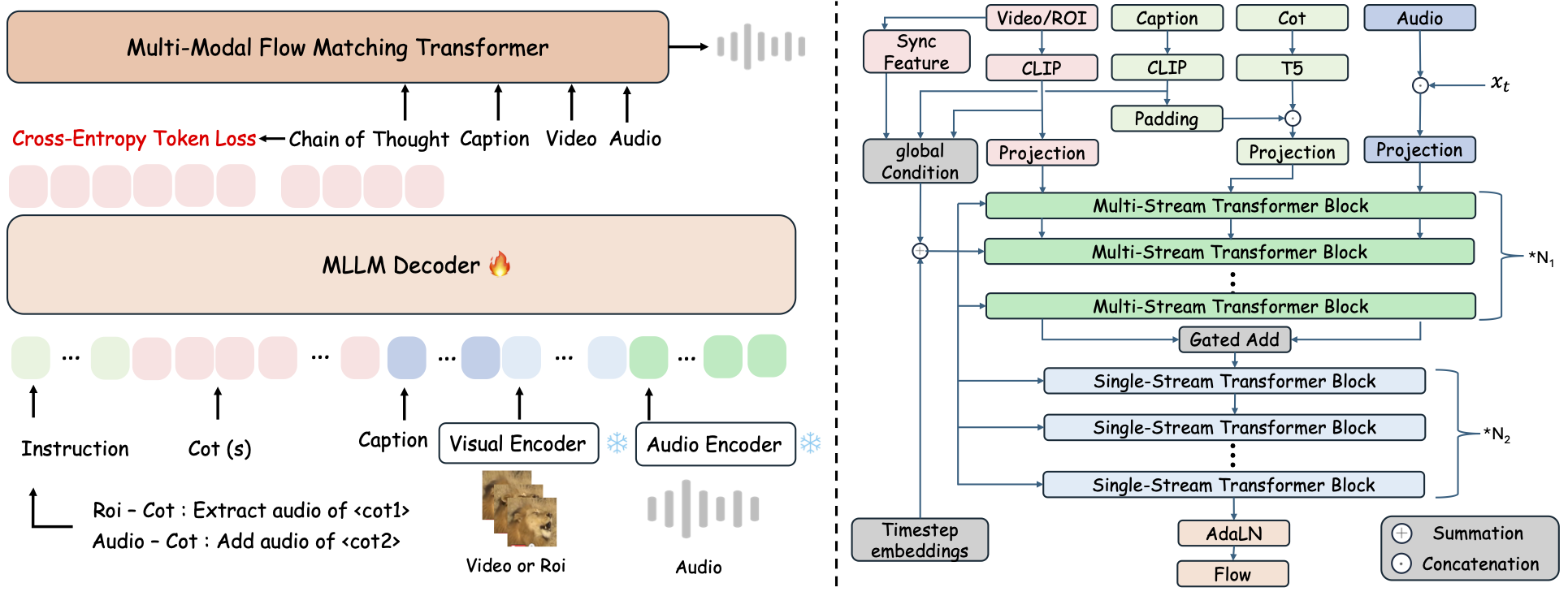

ThinkSound é uma estrutura unificada de geração Any2Audio com fluxo guiado por raciocínio Chain-of-Thought (CoT).

Implementação PyTorch para geração e edição multimodal de áudio: gere ou edite áudio a partir de vídeo, texto e áudio, impulsionado por raciocínio passo a passo de Modelos Multimodais de Linguagem de Grande Escala (MLLMs).

📰 Novidades

- 2025.11.25 🔥Demo Online do PrismAudio está disponível - experimente agora!

- 2025.11.25 🔥Artigo PrismAudio publicado no arXiv, o primeiro framework multi-dimensional CoT-RL para Geração de Áudio a partir de Vídeo!

- 2025.09.19 🎉 ThinkSound foi aceito na Conferência Principal NeurIPS 2025!

- 2025.09.01 Nosso conjunto de dados AudioCoT agora é open-source e está disponível no Hugging Face!

- 2025.07.17 🧠 Fine-tuning habilitado: código de treinamento e ajuste fino agora disponível publicamente, com instruções claras para ajudar você a customizar e expandir o ThinkSound com seus próprios dados.

- 2025.07.15 📦 Instalação e usabilidade simplificadas: dependências no PyPI para fácil configuração multiplataforma; scripts

.batpara Windows automatizam a criação do ambiente e execução dos scripts. - 2025.07.08 🔧 Atualização principal: modelo mais leve e otimização de memória e uso de GPU, agora suporta geração de áudio em larga escala com alto rendimento!

- 2025.07.01 Demo online no Hugging Face Spaces e ModelScope para experiência interativa!

- 2025.07.01 Scripts de inferência e interface web lançados;

- 2025.06 Artigo ThinkSound publicado no arXiv!

- 2025.06 Demo Online está disponível - experimente agora!

🚀 Funcionalidades

- Any2Audio: Gere áudio a partir de modalidades arbitrárias — vídeo, texto, áudio ou suas combinações.

- Video-para-Áudio SOTA: Alcança resultados de ponta em múltiplos benchmarks V2A.

- Raciocínio Guiado por CoT: Raciocínio Chain-of-Thought para geração de áudio composicional e controlável via MLLMs.

- Edição Interativa Centrada em Objetos: Refine ou edite eventos sonoros específicos clicando em objetos visuais ou usando instruções de texto.

- Framework Unificado: Um modelo base suporta geração, edição e fluxo de trabalho interativo.

✨ Visão Geral do Método

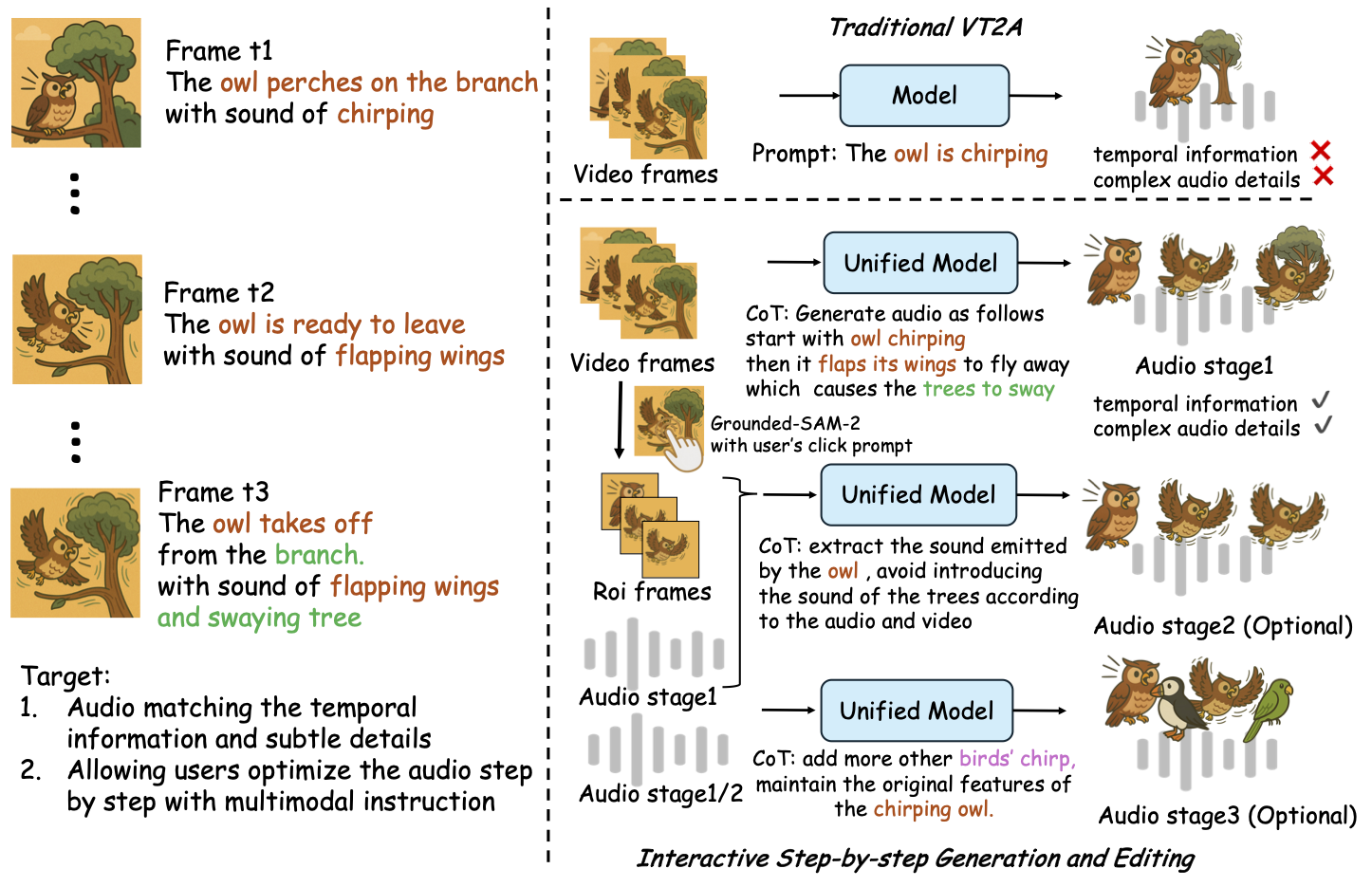

ThinkSound decompõe a geração e edição de áudio em três etapas interativas, todas guiadas por raciocínio Chain-of-Thought (CoT) baseado em MLLM:

- Geração Foley: Gera paisagens sonoras fundamentais, semanticamente e temporalmente alinhadas a partir do vídeo.

- Refinamento Centrado em Objetos: Refina ou adiciona sons para objetos especificados pelo usuário via cliques ou regiões no vídeo.

- Edição de Áudio Direcionada: Modifica o áudio gerado usando instruções de linguagem natural de alto nível.

⚡ Início Rápido

Preparação do Ambiente:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ Dica para Windows:

Usuários do Windows podem simplesmente executar setup_windows.bat (ou dar um duplo clique) para criar automaticamente o ambiente conda, instalar todas as dependências (incluindo o FFmpeg) e baixar o modelo pré-treinado — não é necessário configuração manual.

Certifique-se de quecondaegitestejam instalados e disponíveis no PATH do sistema antes de executar o script.

▶️ Execute a Demonstração

#### Linux/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Você pode usar o script <code>.bat</code> fornecido em vez disso:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>Nota:</strong></p><ul><li><code><caminho-para-seu-vídeo-demo></code>: O caminho para um único vídeo</li>

<li><code>[use-half]</code> (opcional): Adicione use-half ao final para ativar a extração de recursos em precisão reduzida.</li></p><p></ul>---</p><h3>📦 Inferência em Lote</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Use o script <code>.bat</code> equivalente:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>Nota:</strong></p><ul><li><code><video_path></code>: Caminho para o diretório raiz contendo todos os vídeos .mp4 a serem processados (todos os vídeos devem ter a mesma duração).</li>

<li><code><csv_path></code>: Um arquivo CSV com prompts de texto para cada vídeo (veja <code>demo_test.csv</code> para o formato).</li>

<li><code><save_path></code> (opcional): Onde salvar o áudio gerado. O padrão é <code>results/features</code>.</li>

<li><code>[use-half]</code> (opcional): Adicione use-half ao final para habilitar a extração de recursos em meia precisão.</li></p><p></ul>---</p><h3>Uso da Interface Web</h3></p><p>Para uma experiência interativa, inicie a interface web do Gradio:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ Treinar o Modelo</h2></p><p>Veja <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 TODO & Planos Futuros</h2>

<ul><li>- [ ] Lançar um modelo de fundação mais poderoso cobrindo múltiplos domínios para oferecer criação de foley mais envolvente e imersiva</li>

<li>- [ ] Adicionar suporte para modalidades adicionais e tarefas downstream</li>

<li>- [ ] Lançar modelos em diferentes escalas</li>

<li>- [x] Open-source do conjunto de dados AudioCoT e pipeline automatizado</li>

<li>- [x] Lançar scripts de treinamento para os modelos ThinkSound</li>

<li>- [x] Um README de início rápido para Windows, amigável para iniciantes</li>

</ul>---</p><h2>📄 Licença</h2></p><p>Este projeto é lançado sob a Licença Apache 2.0.</p><blockquote><strong>Nota:</strong></blockquote>

<blockquote>O código, modelos e conjunto de dados são <strong>apenas para fins de pesquisa e educação</strong>.</blockquote>

<blockquote><strong>Uso comercial NÃO é permitido.</strong></blockquote>

<blockquote>Para licenciamento comercial, entre em contato com os autores.</blockquote></p><p><strong>📦 Componentes de Terceiros</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (por Stability AI):</li>

</ul>Este repositório inclui um VAE ajustado do <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a>, licenciado sob a <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">Licença de Comunidade Stability AI</a>.

<strong>Uso comercial e redistribuição requerem permissão prévia da Stability AI.</strong></p><ul><li>📘 <strong>Todo o restante do código e modelos</strong> são lançados sob a Licença Apache 2.0.</li></p><p></ul>---</p><h2>Agradecimentos</h2></p><p>Muito obrigado a:</p><ul><li><strong>stable-audio-tools</strong> (por Stability AI):</li>

</ul>Por fornecer uma estrutura de fácil utilização para geração de áudio, bem como o módulo VAE e os pesos.

<ul><li><strong>MMAudio</strong>:</li>

</ul>Pela implementação do backbone MM-DiT no domínio de áudio.</p><hr></p><h2>📖 Citação</h2></p><p>Se você achar o ThinkSound útil em sua pesquisa ou trabalho, por favor cite nosso artigo:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>