ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

Jeśli uważasz, że ten projekt jest przydatny,

gwiazdka ⭐ na GitHubie będzie mile widziana!

ThinkSound to zunifikowany system generowania Any2Audio z dopasowaniem przepływu kierowanym przez rozumowanie Chain-of-Thought (CoT). Implementacja PyTorch dla multimodalnej generacji i edycji dźwięku: generuj lub edytuj dźwięk z wideo, tekstu i dźwięku, wspierana przez krok po kroku rozumowanie z Multimodalnych Dużych Modeli Językowych (MLLM).

📰 Aktualności

- 2025.11.25 🔥Online PrismAudio Demo już dostępne – wypróbuj teraz!

- 2025.11.25 🔥PrismAudio paper opublikowany na arXiv, pierwszy wielowymiarowy framework CoT-RL dla generowania dźwięku z wideo!

- 2025.09.19 🎉 ThinkSound został przyjęty na NeurIPS 2025 Main Conference!

- 2025.09.01 Nasz zbiór danych AudioCoT jest teraz open-source i dostępny na Hugging Face!

- 2025.07.17 🧠 Dostępne dostrajanie: kod treningowy i dostrajania jest już publiczny wraz z jasnymi instrukcjami, które pomogą Ci dostosować i rozszerzyć ThinkSound o własne dane.

- 2025.07.15 📦 Uproszczona instalacja i użyteczność: zależności dostępne na PyPI dla łatwego wdrożenia cross-platform; skrypty Windows

.batautomatyzują tworzenie środowiska i uruchamianie skryptów. - 2025.07.08 🔧 Duża aktualizacja: model odchudzony i zoptymalizowane zużycie pamięci i GPU, teraz obsługuje generowanie dźwięku na dużą skalę!

- 2025.07.01 Demo online na Hugging Face Spaces oraz ModelScope dla interaktywnej prezentacji!

- 2025.07.01 Udostępniono skrypty do wnioskowania oraz interfejs webowy;

- 2025.06 ThinkSound paper opublikowany na arXiv!

- 2025.06 Demo Online już dostępne – wypróbuj teraz!

🚀 Funkcje

- Any2Audio: Generowanie dźwięku z dowolnych modalności — wideo, tekstu, dźwięku lub ich kombinacji.

- Video-to-Audio SOTA: Osiąga najnowocześniejsze wyniki na wielu benchmarkach V2A.

- CoT-Driven Reasoning: Chain-of-Thought do kompozycyjnej i sterowalnej generacji dźwięku przez MLLM.

- Interaktywna Edycja Obiektowa: Ulepszaj lub edytuj konkretne zdarzenia dźwiękowe klikając w obiekty wizualne lub używając instrukcji tekstowych.

- Zunifikowany Framework: Jeden model bazowy obsługuje generowanie, edycję i interaktywny workflow.

✨ Przegląd Metody

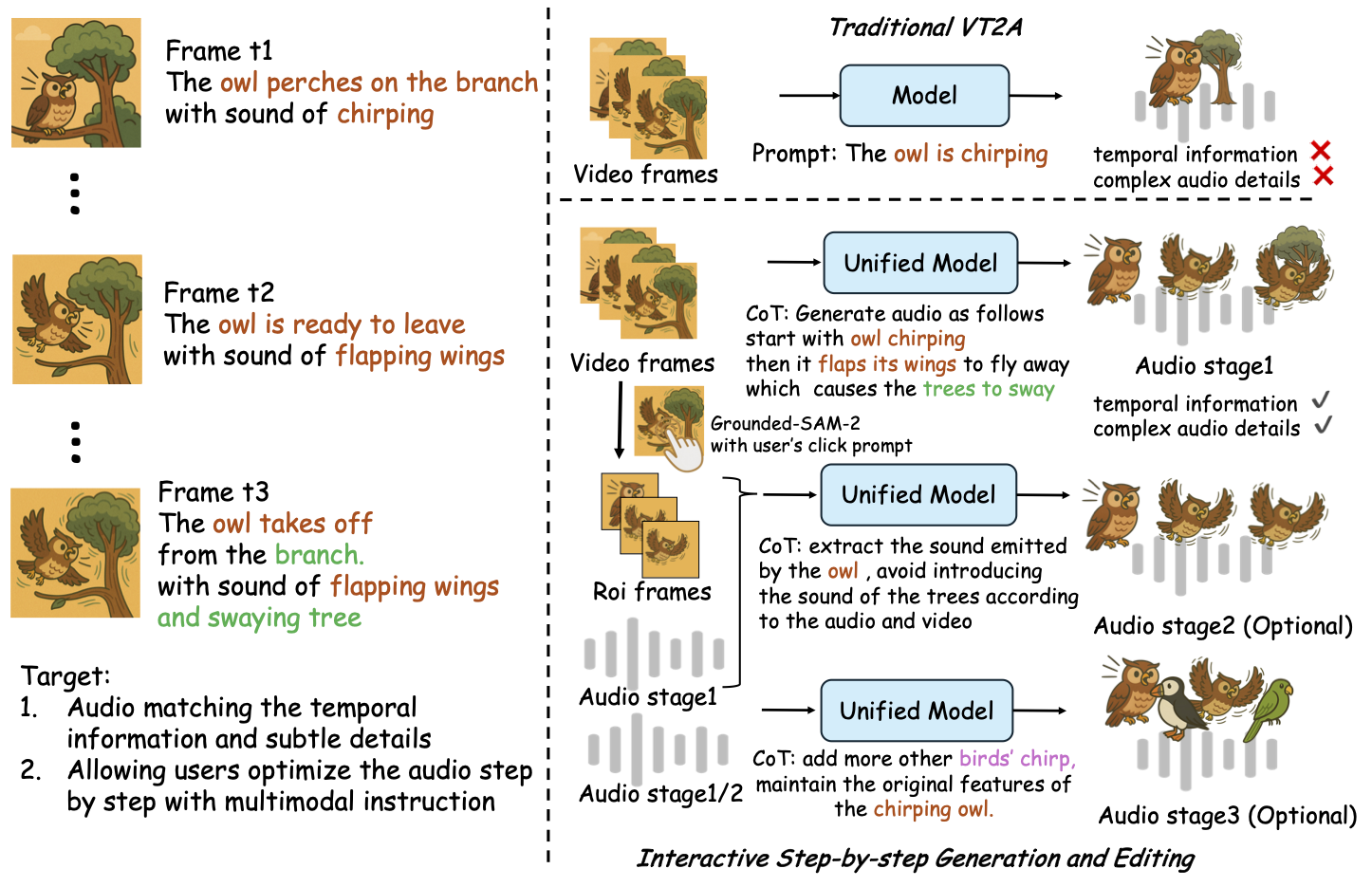

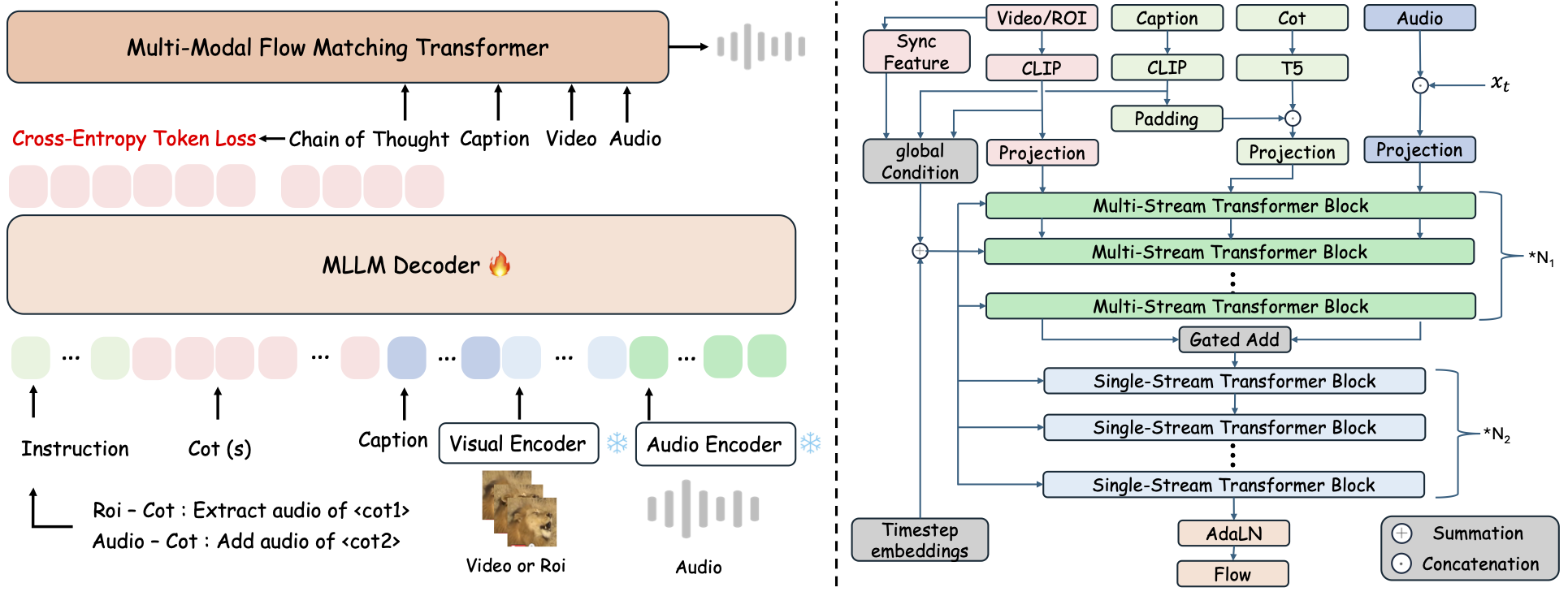

ThinkSound rozbija generowanie i edycję dźwięku na trzy interaktywne etapy, wszystkie sterowane rozumowaniem Chain-of-Thought (CoT) na bazie MLLM:

- Generowanie Foley: Tworzenie podstawowych, semantycznie i czasowo dopasowanych krajobrazów dźwiękowych z wideo.

- Refinacja Obiektowa: Ulepszaj lub dodawaj dźwięki dla wskazanych przez użytkownika obiektów poprzez kliknięcia lub zaznaczenia w wideo.

- Ukierunkowana Edycja Dźwięku: Modyfikuj wygenerowany dźwięk za pomocą wysokopoziomowych poleceń w języku naturalnym.

⚡ Szybki start

Przygotowanie środowiska:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ Wskazówka dla Windows:

Użytkownicy Windows mogą po prostu uruchomić setup_windows.bat (lub kliknąć go dwukrotnie), aby automatycznie utworzyć środowisko conda, zainstalować wszystkie zależności (w tym FFmpeg) i pobrać wytrenowany model — bez konieczności ręcznej konfiguracji.

Przed uruchomieniem skryptu upewnij się, żecondaigitsą zainstalowane i dostępne w zmiennej PATH systemu.

▶️ Uruchom Demo

#### Linux/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Możesz zamiast tego użyć dołączonego skryptu <code>.bat</code>:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>Uwaga:</strong></p><ul><li><code><ścieżka-do-twojego-wideo-demo></code>: Ścieżka do pojedynczego wideo</li>

<li><code>[use-half]</code> (opcjonalnie): Dodaj use-half na końcu, aby włączyć ekstrakcję cech w połowie precyzji.</li></p><p></ul>---</p><h3>📦 Przetwarzanie wsadowe</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Użyj równoważnego skryptu <code>.bat</code>:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>Uwaga:</strong></p><ul><li><code><video_path></code>: Ścieżka do katalogu głównego zawierającego wszystkie filmy .mp4 do przetworzenia (wszystkie filmy muszą mieć taką samą długość).</li>

<li><code><csv_path></code>: Plik CSV z tekstowymi podpowiedziami dla każdego filmu (zobacz <code>demo_test.csv</code> dla formatu).</li>

<li><code><save_path></code> (opcjonalnie): Gdzie zapisać wygenerowane audio. Domyślnie <code>results/features</code>.</li>

<li><code>[use-half]</code> (opcjonalnie): Dodaj use-half na końcu, aby włączyć ekstrakcję cech w trybie półprecyzyjnym.</li></p><p></ul>---</p><h3>Użycie interfejsu webowego</h3></p><p>Aby uzyskać interaktywne doświadczenie, uruchom interfejs webowy Gradio:</p><pre><code class="language-bash">python app.py</code></pre>

<h2>🏋️ Trening modelu</h2></p><p>Zobacz <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 TODO i plany na przyszłość</h2>

<ul><li>- [ ] Wydanie bardziej zaawansowanego modelu bazowego obejmującego wiele domen, zapewniającego bardziej angażujące i immersyjne tworzenie efektów foley</li>

<li>- [ ] Dodanie obsługi dodatkowych modalności i zadań pochodnych</li>

<li>- [ ] Wydanie modeli o różnych skalach</li>

<li>- [x] Otwarcie źródła zestawu danych AudioCoT oraz automatycznej linii produkcyjnej</li>

<li>- [x] Wydanie skryptów treningowych dla modeli ThinkSound</li>

<li>- [x] Przyjazny dla początkujących README z szybkim startem na Windows</li>

</ul>---</p><h2>📄 Licencja</h2></p><p>Ten projekt jest wydany na licencji Apache 2.0.</p><blockquote><strong>Uwaga:</strong></blockquote>

<blockquote>Kod, modele i zestaw danych są <strong>przeznaczone wyłącznie do celów badawczych i edukacyjnych</strong>.</blockquote>

<blockquote><strong>Użycie komercyjne NIE jest dozwolone.</strong></blockquote>

<blockquote>W sprawie licencji komercyjnych prosimy o kontakt z autorami.</blockquote></p><p><strong>📦 Komponenty zewnętrzne</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (by Stability AI):</li>

</ul>Repozytorium zawiera dostrojony VAE z <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a>, udostępniony na <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">Stability AI Community License</a>.

<strong>Użycie komercyjne i dystrybucja wymagają wcześniejszej zgody Stability AI.</strong></p><ul><li>📘 <strong>Wszelki inny kod i modele</strong> wydawane są na licencji Apache 2.0.</li></p><p></ul>---</p><h2>Podziękowania</h2></p><p>

Wielkie podziękowania dla:</p><ul><li><strong>stable-audio-tools</strong> (od Stability AI):</li>

</ul>Za udostępnienie łatwego w użyciu frameworka do generowania dźwięku, a także modułu VAE i wag.

<ul><li><strong>MMAudio</strong>:</li>

</ul>Za implementację szkieletu MM-DiT w dziedzinie audio.</p><hr></p><h2>📖 Cytowanie</h2></p><p>Jeśli ThinkSound okazał się przydatny w Twoich badaniach lub pracy, prosimy o cytowanie naszej publikacji:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>