ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

Als je dit project nuttig vindt,

wordt een ster ⭐ op GitHub zeer gewaardeerd!

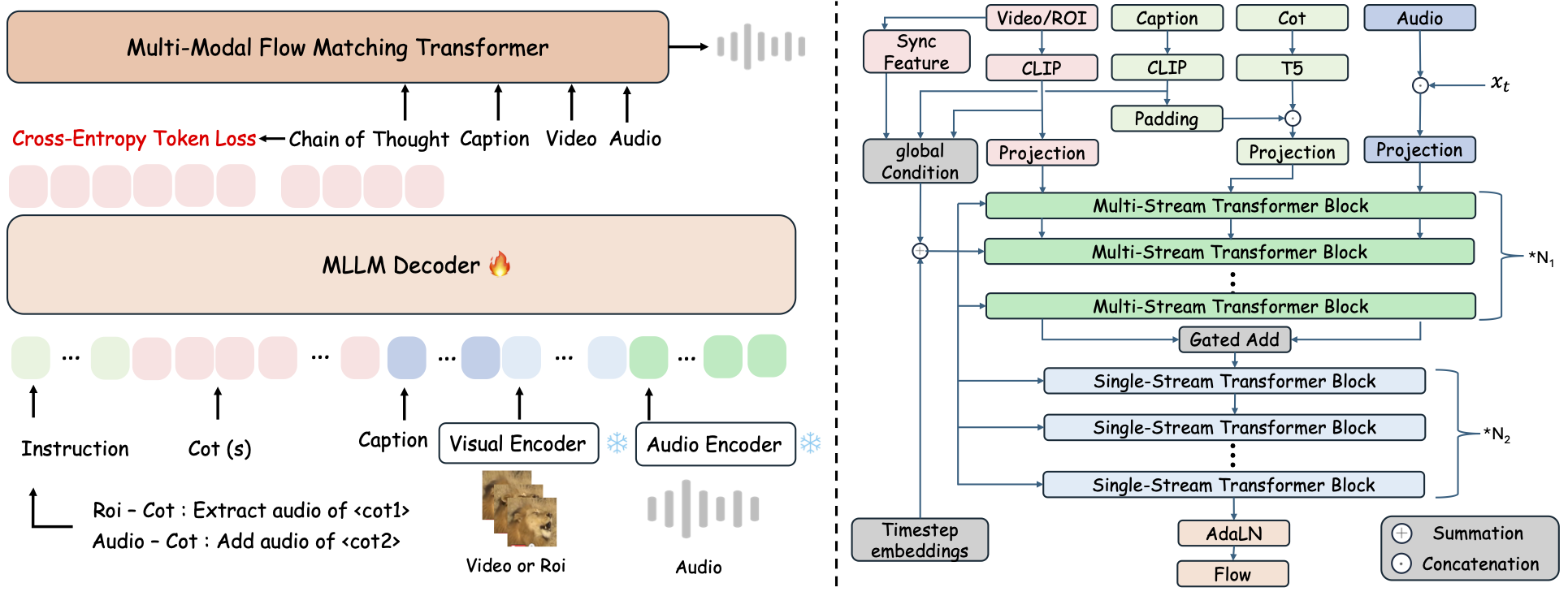

ThinkSound is een uniform Any2Audio generatiekader met flow matching gestuurd door Chain-of-Thought (CoT) redeneren. PyTorch-implementatie voor multimodale audiogeneratie en -bewerking: genereer of bewerk audio vanuit video, tekst en audio, aangedreven door stapsgewijze redenering van Multimodale Grote Taalmodellen (MLLMs).

📰 Nieuws

- 2025.11.25 🔥Online PrismAudio Demo is live - probeer het nu uit!

- 2025.11.25 🔥PrismAudio paper gepubliceerd op arXiv, het eerste multi-dimensionale CoT-RL framework voor Video-naar-Audio Generatie!

- 2025.09.19 🎉 ThinkSound is geaccepteerd voor de NeurIPS 2025 Hoofdconferentie!

- 2025.09.01 Onze AudioCoT-dataset is nu open-source en beschikbaar op Hugging Face!

- 2025.07.17 🧠 Finetuning mogelijk: trainings- en finetuningcode nu openbaar beschikbaar, met duidelijke instructies om ThinkSound aan te passen en uit te breiden met eigen data.

- 2025.07.15 📦 Vereenvoudigde installatie en bruikbaarheid: afhankelijkheden op PyPI voor eenvoudige cross-platform installatie; Windows

.bat-scripts automatiseren het aanmaken van omgevingen en het uitvoeren van scripts. - 2025.07.08 🔧 Grote update: model is lichter gemaakt en geheugen- en GPU-gebruik geoptimaliseerd, ondersteunt nu grootschalige audio-generatie met hoge doorvoer!

- 2025.07.01 Online demo op Hugging Face Spaces en ModelScope voor interactieve ervaring!

- 2025.07.01 Inferencescripts en webinterface uitgebracht;

- 2025.06 ThinkSound paper gepubliceerd op arXiv!

- 2025.06 Online Demo is live - probeer het nu uit!

🚀 Functionaliteiten

- Any2Audio: Genereer audio vanuit willekeurige modaliteiten — video, tekst, audio, of combinaties hiervan.

- Video-naar-Audio SOTA: Behaalt state-of-the-art resultaten op meerdere V2A-benchmarks.

- CoT-Gestuurde Redenering: Chain-of-Thought redenering voor compositieve en controleerbare audiogeneratie via MLLMs.

- Interactieve Objectgerichte Bewerking: Verfijn of bewerk specifieke geluidsgebeurtenissen door te klikken op visuele objecten of tekstinstructies te gebruiken.

- Uniform Framework: Eén basismodel ondersteunt generatie, bewerking en interactieve workflow.

✨ Methode Overzicht

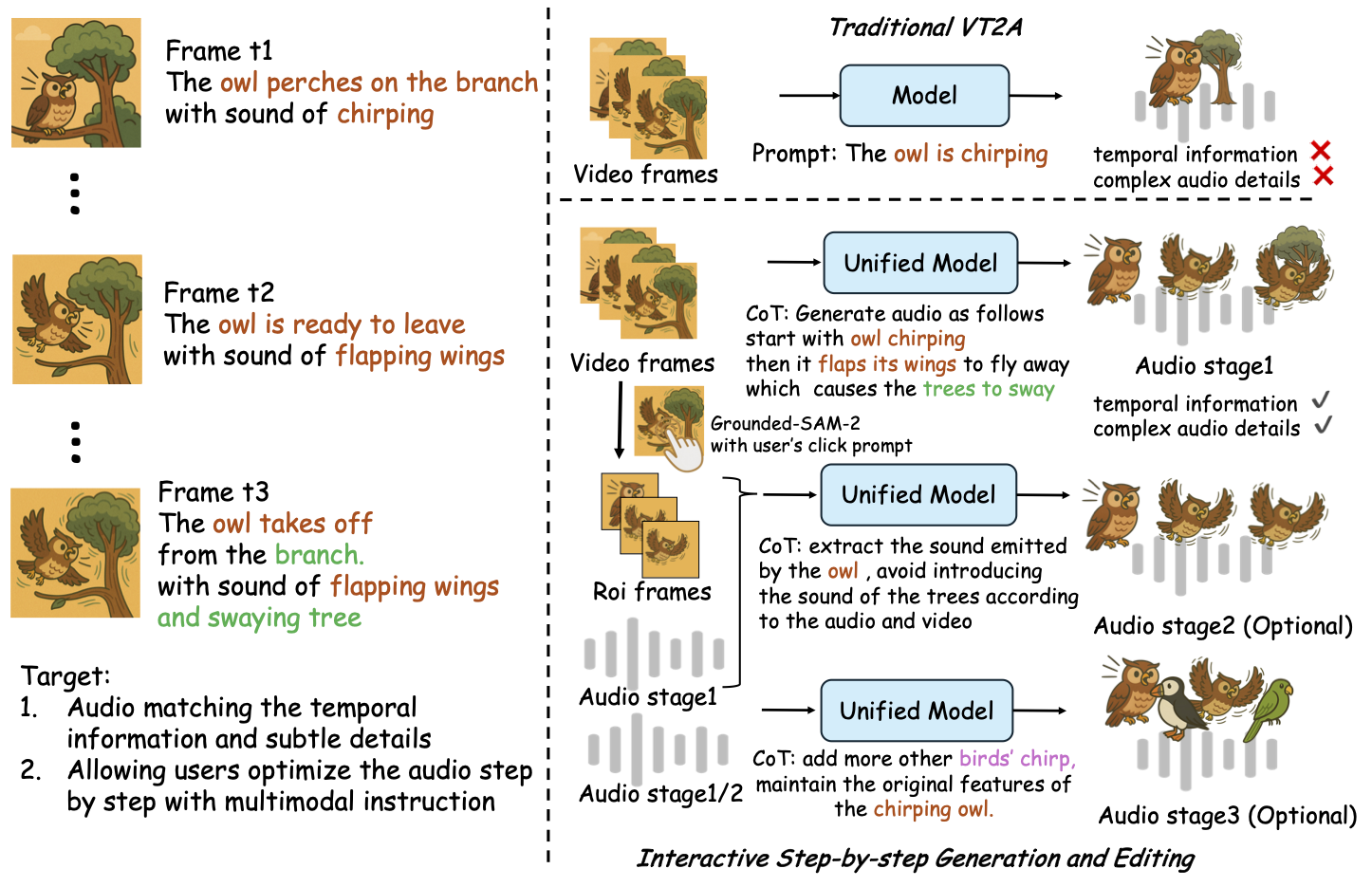

ThinkSound splitst audiogeneratie en -bewerking op in drie interactieve fasen, allen gestuurd door MLLM-gebaseerde Chain-of-Thought (CoT) redenering:

- Foley Generatie: Genereer fundamentele, semantisch en temporeel uitgelijnde soundscapes vanuit video.

- Objectgerichte Verfijning: Verfijn of voeg geluiden toe voor door de gebruiker gespecificeerde objecten via klikken of regio's in de video.

- Gerichte Audio Bewerking: Pas de gegenereerde audio aan met behulp van hoog-natuurlijke taalopdrachten.

⚡ Snelle Start

Omgevingsvoorbereiding:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ Windows Tip:

Windows-gebruikers kunnen eenvoudig setup_windows.bat uitvoeren (of dubbelklikken) om automatisch de conda-omgeving aan te maken, alle afhankelijkheden te installeren (inclusief FFmpeg) en het voorgetrainde model te downloaden — geen handmatige installatie vereist.

Zorg ervoor datcondaengitzijn geïnstalleerd en beschikbaar zijn in je systeem-PATH voordat je het script uitvoert.

▶️ Demo uitvoeren

#### Linux/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>U kunt in plaats daarvan het meegeleverde <code>.bat</code>-script gebruiken:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>Opmerking:</strong></p><ul><li><code><pad-naar-je-demo-video></code>: Het pad naar een enkele video</li>

<li><code>[use-half]</code> (optioneel): Voeg use-half toe aan het einde om halfprecisie feature-extractie in te schakelen.</li></p><p></ul>---</p><h3>📦 Batch-inferentie</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Gebruik het equivalente <code>.bat</code>-script:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>Opmerking:</strong></p><ul><li><code><video_path></code>: Pad naar de hoofdmap met alle .mp4-video’s die verwerkt moeten worden (alle video’s moeten even lang zijn).</li>

<li><code><csv_path></code>: Een CSV-bestand met tekstprompts voor elke video (zie <code>demo_test.csv</code> voor het formaat).</li>

<li><code><save_path></code> (optioneel): Locatie om gegenereerde audio op te slaan. Standaard <code>results/features</code>.</li>

<li><code>[use-half]</code> (optioneel): Voeg use-half toe aan het einde om extractie met halve precisie in te schakelen.</li></p><p></ul>---</p><h3>Gebruik van de webinterface</h3></p><p>Voor een interactieve ervaring start je de Gradio webinterface:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ Train het model</h2></p><p>Zie <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 TODO & Toekomstplannen</h2>

<ul><li>- [ ] Uitbrengen van een krachtiger basismodel dat meerdere domeinen bestrijkt voor meer boeiende en meeslepende foley-creatie</li>

<li>- [ ] Ondersteuning toevoegen voor extra modaliteiten en vervolgopdrachten</li>

<li>- [ ] Modellen uitbrengen op verschillende schalen</li>

<li>- [x] Open-source AudioCoT dataset en geautomatiseerde pipeline</li>

<li>- [x] Trainingsscripts voor ThinkSound-modellen uitbrengen</li>

<li>- [x] Een beginnersvriendelijke Windows quick-start README</li>

</ul>---</p><h2>📄 Licentie</h2></p><p>Dit project wordt uitgebracht onder de Apache 2.0-licentie.</p><blockquote><strong>Let op:</strong></blockquote>

<blockquote>De code, modellen en dataset zijn <strong>alleen voor onderzoeks- en educatieve doeleinden</strong>.</blockquote>

<blockquote><strong>Commercieel gebruik is NIET toegestaan.</strong></blockquote>

<blockquote>Voor commerciële licenties kunt u contact opnemen met de auteurs.</blockquote></p><p><strong>📦 Componenten van derden</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (door Stability AI):</li>

</ul>Deze repository bevat een fijn-afgestemde VAE van <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a>, gelicentieerd onder de <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">Stability AI Community License</a>.

<strong>Commercieel gebruik en herdistributie vereisen voorafgaande toestemming van Stability AI.</strong></p><ul><li>📘 <strong>Alle overige code en modellen</strong> worden uitgebracht onder de Apache License 2.0.</li></p><p></ul>---</p><h2>Dankbetuigingen</h2></p><p>Veel dank aan:</p><ul><li><strong>stable-audio-tools</strong> (door Stability AI):</li>

</ul>Voor het bieden van een gebruiksvriendelijk framework voor audiogeneratie, evenals de VAE-module en gewichten.

<ul><li><strong>MMAudio</strong>:</li>

</ul>Voor de implementatie van de MM-DiT backbone in het audiodomein.</p><hr></p><h2>📖 Referentie</h2></p><p>Als u ThinkSound nuttig vindt in uw onderzoek of werk, citeer dan onze paper:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>