ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

このプロジェクトが役立つと感じた場合、

GitHubでスター ⭐ をいただけると嬉しいです!

ThinkSound は、Chain-of-Thought(CoT)推論によるフロー・マッチングを活用した統合型Any2Audio生成フレームワークです。 PyTorchによるマルチモーダル音声生成および編集の実装:動画、テキスト、音声から音声を生成・編集可能。マルチモーダル大規模言語モデル(MLLM)の段階的な推論によって強化されています。

📰 ニュース

- 2025.11.25 🔥オンラインPrismAudioデモ公開 - 今すぐお試しください!

- 2025.11.25 🔥PrismAudio論文がarXivに公開、初の多次元CoT-RLフレームワークによるVideo-to-Audio生成!

- 2025.09.19 🎉 ThinkSoundがNeurIPS 2025本会議に採択されました!

- 2025.09.01 AudioCoTデータセットがオープンソース化され、Hugging Faceで入手可能になりました!

- 2025.07.17 🧠 ファインチューニング対応:トレーニングおよびファインチューニングコードを公開、独自データでThinkSoundをカスタマイズ・拡張するための明確な使用方法も提供。

- 2025.07.15 📦 インストール・利用が簡単に:PyPI依存関係でクロスプラットフォーム環境構築が容易に。Windows用

.batスクリプトで環境作成・スクリプト実行を自動化。 - 2025.07.08 🔧 大幅アップデート:モデルの軽量化、メモリ・GPU使用最適化により、大規模な高スループット音声生成を実現!

- 2025.07.01 Hugging Face SpacesおよびModelScopeでオンラインデモ公開、インタラクティブ体験が可能!

- 2025.07.01 推論スクリプトとWebインターフェース公開;

- 2025.06 ThinkSound論文がarXivに公開!

- 2025.06 オンラインデモ公開 - 今すぐお試しください!

🚀 特徴

- Any2Audio: 任意のモダリティ(動画、テキスト、音声または組み合わせ)から音声を生成。

- Video-to-Audio SOTA: 複数のV2Aベンチマークで最先端の結果を達成。

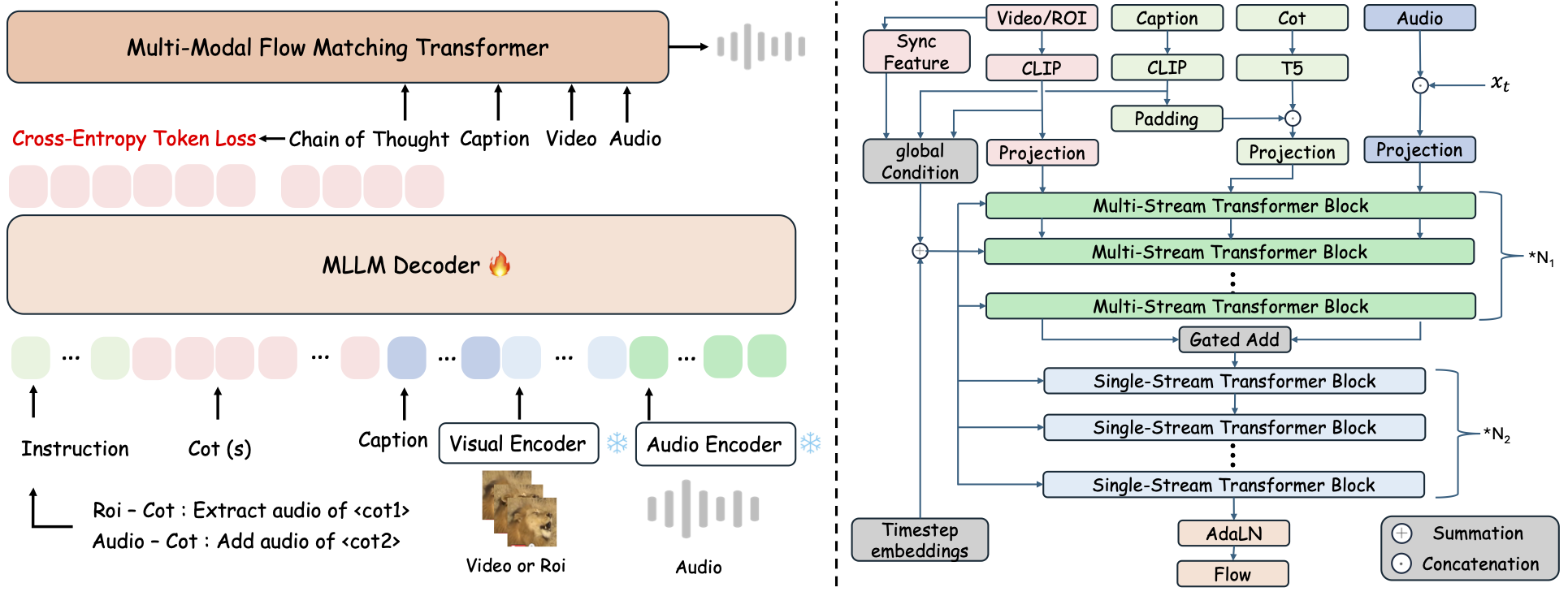

- CoT駆動推論: MLLMを利用したChain-of-Thought推論による構成的かつ制御可能な音声生成。

- インタラクティブなオブジェクト中心編集: 視覚オブジェクトのクリックやテキスト指示で特定の音イベントを編集・改良。

- 統一フレームワーク: ひとつの基盤モデルで生成、編集、インタラクティブなワークフローをサポート。

✨ 手法概要

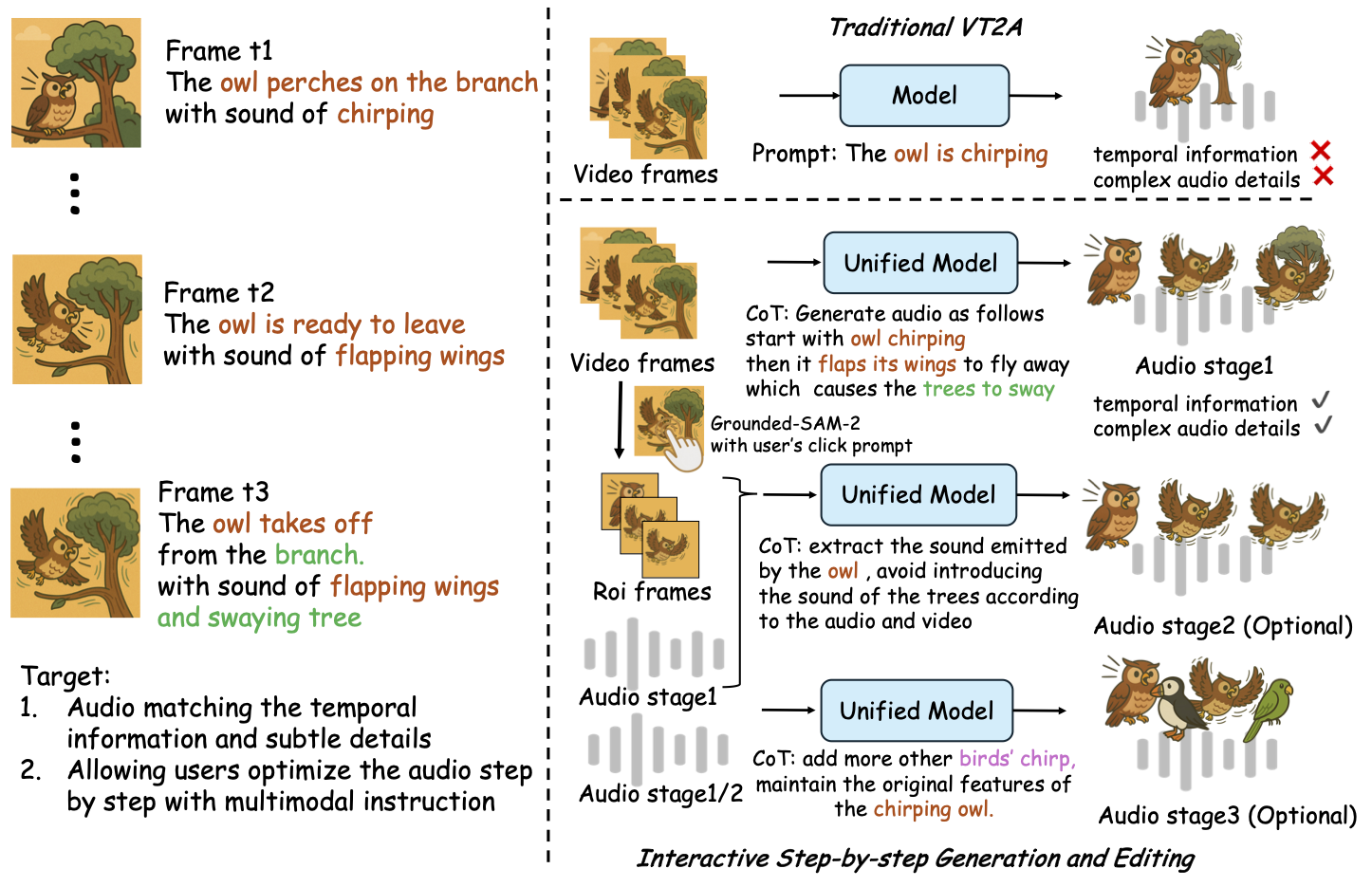

ThinkSoundは音声生成と編集を、MLLMベースのChain-of-Thought(CoT)推論で導かれる3つのインタラクティブな段階に分解します:

- フォーリー生成: 動画から意味的・時間的に整合した基礎的なサウンドスケープを生成。

- オブジェクト中心の改良: 動画内のクリックや領域指定で、ユーザー指定オブジェクトの音を追加・改良。

- ターゲット音声編集: 高レベルな自然言語指示で生成済み音声を修正。

⚡ クイックスタート

環境準備:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ Windowsのヒント:

Windowsユーザーは、setup_windows.bat を実行(またはダブルクリック)するだけで、自動的にconda環境が作成され、すべての依存関係(FFmpegを含む)がインストールされ、学習済みモデルがダウンロードされます — 手動でのセットアップは不要です。

スクリプトを実行する前に、condaおよびgitがインストールされており、システムPATHに追加されていることを確認してください。

▶️ デモの実行

#### Linux/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>代わりに、用意された <code>.bat</code> スクリプトを使用できます。</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>注意:</strong></p><ul><li><code><path-to-your-demo-video></code>: 単一ビデオへのパス</li>

<li><code>[use-half]</code>(オプション): 最後にuse-halfを追加して半精度特徴抽出を有効にします。</li></p><p></ul>---</p><h3>📦 バッチ推論</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>同等の <code>.bat</code> スクリプトを使用してください:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>注意:</strong></p><ul><li><code><video_path></code>: 処理するすべての.mp4動画を含むルートディレクトリへのパス(すべての動画は同じ長さである必要があります)。</li>

<li><code><csv_path></code>: 各動画に対応するテキストプロンプトが記載されたCSVファイル(形式は<code>demo_test.csv</code>を参照)。</li>

<li><code><save_path></code>(オプション): 生成された音声の保存先。デフォルトは<code>results/features</code>。</li>

<li><code>[use-half]</code>(オプション): 最後にuse-halfを追加すると半精度特徴量抽出を有効化します。</li></p><p></ul>---</p><h3>Webインターフェースの利用</h3></p><p>インタラクティブな操作を行うには、GradioのWebインターフェースを起動してください。</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ モデルのトレーニング</h2></p><p><a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a> を参照してください</p><hr></p><h2>📝 TODO & 今後の計画</h2>

<ul><li>- [ ] より強力な基礎モデルを公開し、複数のドメインをカバーしてより魅力的で没入感のあるフォーリー作成を提供</li>

<li>- [ ] 追加のモダリティおよび下流タスクへの対応を追加</li>

<li>- [ ] 異なるスケールのモデルを公開</li>

<li>- [x] AudioCoTデータセットおよび自動化パイプラインのオープンソース化</li>

<li>- [x] ThinkSoundモデル用のトレーニングスクリプト公開</li>

<li>- [x] 初心者向けWindowsクイックスタートREADME</li>

</ul>---</p><h2>📄 ライセンス</h2></p><p>このプロジェクトはApache 2.0ライセンスの下で公開されています。</p><blockquote><strong>注意:</strong></blockquote>

<blockquote>コード、モデル、データセットは <strong>研究および教育目的のみ</strong> で利用可能です。</blockquote>

<blockquote><strong>商用利用は許可されていません。</strong></blockquote>

<blockquote>商用ライセンスについては著者にお問い合わせください。</blockquote></p><p><strong>📦 サードパーティコンポーネント</strong></p><ul><li><strong>Stable Audio Open VAE</strong>(Stability AIによる):</li>

</ul>このリポジトリには <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a> からファインチューニングされたVAEが含まれており、<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">Stability AI Community License</a>の下でライセンスされています。

<strong>商用利用および再配布にはStability AIの事前許可が必要です。</strong></p><ul><li>📘 <strong>その他のコードおよびモデル</strong> はApache License 2.0の下で公開されています。</li></p><p></ul>---</p><h2>謝辞</h2></p><p>感謝:</p><ul><li><strong>stable-audio-tools</strong>(Stability AI 提供):</li>

</ul>音声生成のための使いやすいフレームワーク、ならびにVAEモジュールと重みをご提供いただきました。

<ul><li><strong>MMAudio</strong>:</li>

</ul>オーディオ領域におけるMM-DiTバックボーンの実装に感謝します。</p><hr></p><h2>📖 引用</h2></p><p>もしThinkSoundが研究や業務で役立った場合は、ぜひ私たちの論文を引用してください:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>