ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

Se trovi utile questo progetto,

una stella ⭐ su GitHub sarebbe molto apprezzata!

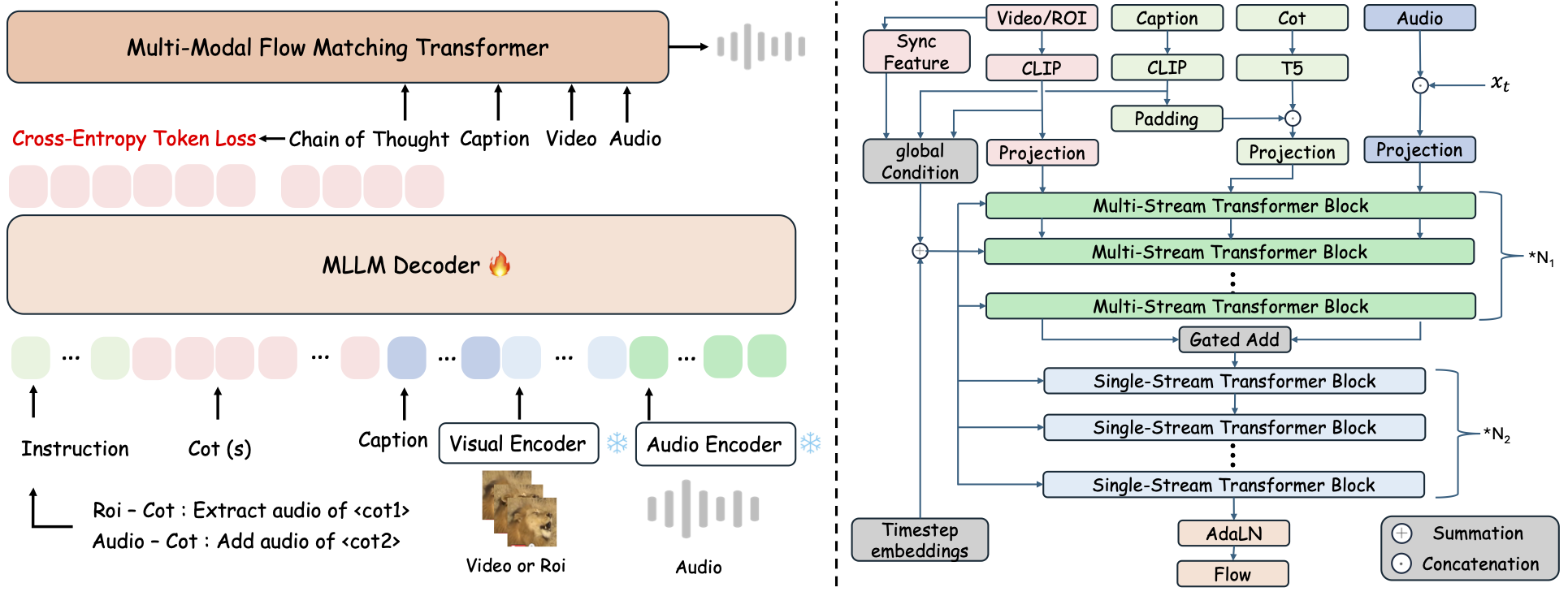

ThinkSound è un framework unificato per la generazione Any2Audio con flow matching guidato dal ragionamento Chain-of-Thought (CoT).

Implementazione PyTorch per la generazione e modifica multimodale di audio: genera o modifica audio da video, testo e audio, alimentata dal ragionamento step-by-step dei Modelli Multimodali di Linguaggio di Grandi Dimensioni (MLLMs).

📰 Novità

- 2025.11.25 🔥Demo PrismAudio Online attivo - provalo ora!

- 2025.11.25 🔥Articolo PrismAudio pubblicato su arXiv, il primo framework multi-dimensionale CoT-RL per la generazione Video-to-Audio!

- 2025.09.19 🎉 ThinkSound è stato accettato alla Conferenza Principale NeurIPS 2025!

- 2025.09.01 Il nostro dataset AudioCoT è ora open-source e disponibile su Hugging Face!

- 2025.07.17 🧠 Fine-tuning abilitato: codice per training e fine-tuning ora pubblico, con istruzioni dettagliate per personalizzare ed estendere ThinkSound con i tuoi dati.

- 2025.07.15 📦 Installazione e usabilità semplificate: dipendenze su PyPI per setup facile cross-platform; script

.batper Windows automatizzano la creazione dell'ambiente e l'esecuzione degli script. - 2025.07.08 🔧 Aggiornamento importante: modello alleggerito e memoria/GPU ottimizzati, ora supporta generazione audio ad alta velocità su larga scala!

- 2025.07.01 Demo online su Hugging Face Spaces e ModelScope per esperienza interattiva!

- 2025.07.01 Rilasciati script di inferenza e interfaccia web;

- 2025.06 Articolo ThinkSound pubblicato su arXiv!

- 2025.06 Demo Online attivo - provalo ora!

🚀 Funzionalità

- Any2Audio: Genera audio da modalità arbitrarie — video, testo, audio, o loro combinazioni.

- Video-to-Audio SOTA: Risultati all'avanguardia su diversi benchmark V2A.

- Ragionamento CoT-Driven: Ragionamento Chain-of-Thought per generazione audio composizionale e controllabile tramite MLLMs.

- Editing Interattivo Oggetto-centrico: Raffina o modifica specifici eventi sonori cliccando su oggetti visivi o usando istruzioni testuali.

- Framework Unificato: Un unico modello di base supporta generazione, editing e flusso di lavoro interattivo.

✨ Panoramica del Metodo

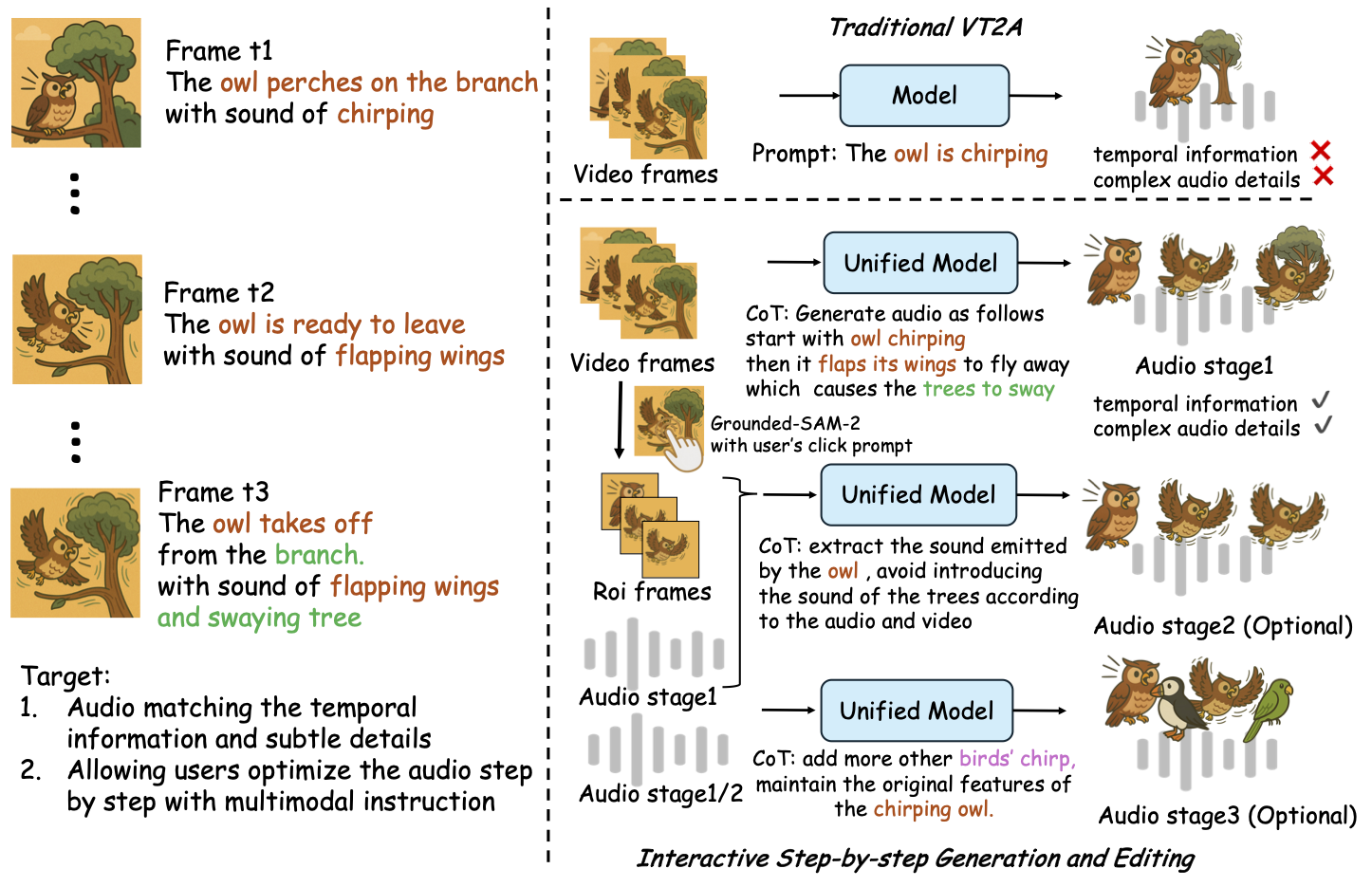

ThinkSound scompone generazione ed editing audio in tre fasi interattive, tutte guidate dal ragionamento Chain-of-Thought (CoT) basato su MLLM:

- Foley Generation: Genera paesaggi sonori fondamentali, semanticamente e temporalmente allineati, dal video.

- Object-Centric Refinement: Raffina o aggiungi suoni per oggetti specificati dall'utente tramite click o regioni nel video.

- Targeted Audio Editing: Modifica l'audio generato usando istruzioni in linguaggio naturale di alto livello.

⚡ Avvio rapido

Preparazione dell’ambiente:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ Suggerimento per Windows:

Gli utenti Windows possono semplicemente eseguire setup_windows.bat (o farci doppio clic) per creare automaticamente l'ambiente conda, installare tutte le dipendenze (incluso FFmpeg) e scaricare il modello pre-addestrato — nessuna configurazione manuale richiesta.

Assicurati checondaegitsiano installati e disponibili nel PATH di sistema prima di eseguire lo script.

▶️ Esegui la Demo

#### Linux/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>In alternativa, puoi utilizzare lo script <code>.bat</code> fornito:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>Nota:</strong></p><ul><li><code><percorso-al-tuo-video-demo></code>: Il percorso a un singolo video</li>

<li><code>[usa-half]</code> (opzionale): Aggiungi usa-half alla fine per abilitare l'estrazione delle caratteristiche in mezza precisione.</li></p><p></ul>---</p><h3>📦 Inferenza in Batch</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Usa lo script <code>.bat</code> equivalente:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>Nota:</strong></p><ul><li><code><video_path></code>: Percorso alla directory principale contenente tutti i video .mp4 da elaborare (tutti i video devono avere la stessa durata).</li>

<li><code><csv_path></code>: Un file CSV con i prompt di testo per ciascun video (vedi <code>demo_test.csv</code> per il formato).</li>

<li><code><save_path></code> (opzionale): Dove salvare l'audio generato. Il valore predefinito è <code>results/features</code>.</li>

<li><code>[use-half]</code> (opzionale): Aggiungi use-half alla fine per abilitare l'estrazione delle feature in mezza precisione.</li></p><p></ul>---</p><h3>Utilizzo dell'interfaccia web</h3></p><p>Per un'esperienza interattiva, avvia l'interfaccia web Gradio:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ Allena il Modello</h2></p><p>Vedi <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 TODO & Piani Futuri</h2>

<ul><li>- [ ] Rilasciare un modello di base più potente che copra più domini per offrire una creazione di foley più coinvolgente e immersiva</li>

<li>- [ ] Aggiungere supporto per ulteriori modalità e compiti downstream</li>

<li>- [ ] Rilasciare modelli di diverse dimensioni</li>

<li>- [x] Open-source del dataset AudioCoT e pipeline automatizzata</li>

<li>- [x] Rilasciare gli script di addestramento per i modelli ThinkSound</li>

<li>- [x] Un README rapido per Windows adatto ai principianti</li>

</ul>---</p><h2>📄 Licenza</h2></p><p>Questo progetto è rilasciato sotto la Licenza Apache 2.0.</p><blockquote><strong>Nota:</strong></blockquote>

<blockquote>Il codice, i modelli e il dataset sono <strong>solo per scopi di ricerca ed educativi</strong>.</blockquote>

<blockquote><strong>L'uso commerciale NON è consentito.</strong></blockquote>

<blockquote>Per la licenza commerciale, si prega di contattare gli autori.</blockquote></p><p><strong>📦 Componenti di Terze Parti</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (di Stability AI):</li>

</ul>Questo repository include un VAE ottimizzato da <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a>, concesso in licenza secondo la <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">Stability AI Community License</a>.

<strong>L'uso commerciale e la redistribuzione richiedono il permesso preventivo di Stability AI.</strong></p><ul><li>📘 <strong>Tutto il resto del codice e dei modelli</strong> è rilasciato sotto la Licenza Apache 2.0.</li></p><p></ul>---</p><h2>Ringraziamenti</h2></p><p>Molte grazie a:</p><ul><li><strong>stable-audio-tools</strong> (di Stability AI):</li>

</ul>Per aver fornito un framework facile da usare per la generazione audio, oltre al modulo VAE e ai relativi pesi.

<ul><li><strong>MMAudio</strong>:</li>

</ul>Per l'implementazione dell'architettura MM-DiT nel dominio audio.</p><hr></p><h2>📖 Citazione</h2></p><p>Se trovi ThinkSound utile per la tua ricerca o lavoro, cita il nostro articolo:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>