ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

यदि आपको यह प्रोजेक्ट उपयोगी लगे,

GitHub पर एक स्टार ⭐ देना अत्यंत सराहनीय होगा!

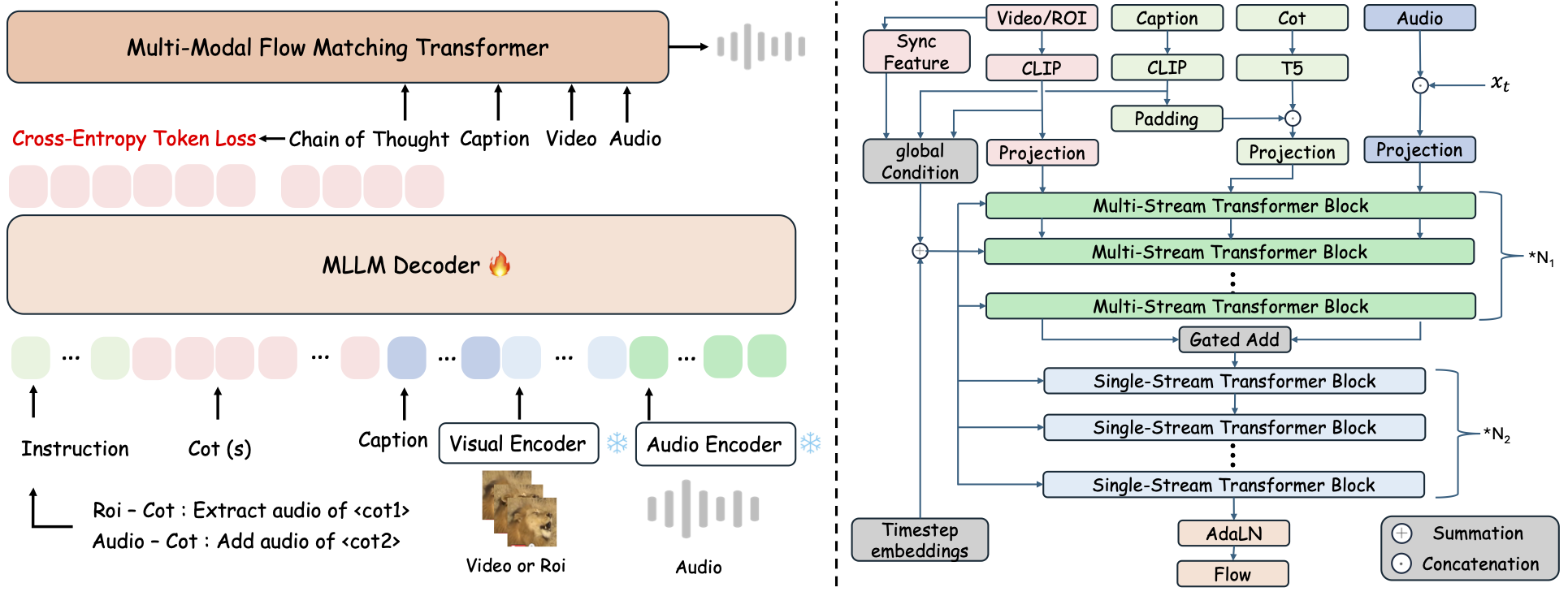

ThinkSound एक एकीकृत Any2Audio जनरेशन फ्रेमवर्क है, जिसमें Chain-of-Thought (CoT) रीजनिंग द्वारा फ्लो मैचिंग का मार्गदर्शन किया जाता है।

मल्टीमोडल ऑडियो जेनरेशन और एडिटिंग के लिए PyTorch इम्प्लीमेंटेशन: वीडियो, टेक्स्ट और ऑडियो से ऑडियो जनरेट या एडिट करें, मल्टीमोडल लार्ज लैंग्वेज मॉडल्स (MLLMs) की स्टेप-बाय-स्टेप रीजनिंग द्वारा संचालित।

📰 समाचार

- 2025.11.25 🔥ऑनलाइन PrismAudio डेमो लाइव है - अभी आज़माएँ!

- 2025.11.25 🔥PrismAudio पेपर arXiv पर जारी, वीडियो-से-ऑडियो जेनरेशन के लिए पहला मल्टी-डायमेंशनल CoT-RL फ्रेमवर्क!

- 2025.09.19 🎉 ThinkSound को NeurIPS 2025 मुख्य सम्मेलन में स्वीकार किया गया है!

- 2025.09.01 हमारा AudioCoT डेटासेट अब ओपन-सोर्स है और Hugging Face पर उपलब्ध है!

- 2025.07.17 🧠 फाइनट्यूनिंग सक्षम: ट्रेनिंग और फाइनट्यूनिंग कोड अब सार्वजनिक रूप से उपलब्ध है, स्पष्ट यूसेज निर्देशों के साथ ताकि आप अपने स्वयं के डेटा के साथ ThinkSound को कस्टमाइज़ और विस्तारित कर सकें।

- 2025.07.15 📦 आसान इंस्टॉलेशन और उपयोगिता: PyPI पर डिपेंडेंसीज़ के साथ आसान क्रॉस-प्लेटफॉर्म सेटअप; Windows

.batस्क्रिप्ट्स से एनवायरनमेंट बनाना और स्क्रिप्ट चलाना स्वचालित। - 2025.07.08 🔧 मुख्य अपडेट: मॉडल हल्का किया गया और मेमोरी व GPU उपयोग को ऑप्टिमाइज़ किया गया, अब बड़े पैमाने पर हाई-थ्रूपुट ऑडियो जेनरेशन को सपोर्ट करता है!

- 2025.07.01 Hugging Face Spaces और ModelScope पर इंटरएक्टिव अनुभव के लिए ऑनलाइन डेमो!

- 2025.07.01 इनफरेंस स्क्रिप्ट्स और वेब इंटरफेस जारी किए गए;

- 2025.06 ThinkSound पेपर arXiv पर जारी!

- 2025.06 ऑनलाइन डेमो लाइव है - अभी आज़माएँ!

🚀 विशेषताएँ

- Any2Audio: किसी भी मोडालिटी से ऑडियो जनरेट करें — वीडियो, टेक्स्ट, ऑडियो या उनके संयोजन।

- वीडियो-से-ऑडियो SOTA: कई V2A बेंचमार्क्स पर स्टेट-ऑफ-द-आर्ट परिणाम प्राप्त करता है।

- CoT-ड्रिवन रीजनिंग: संयोजित और नियंत्रित ऑडियो जेनरेशन के लिए MLLMs द्वारा चेन-ऑफ-थॉट रीजनिंग।

- इंटरएक्टिव ऑब्जेक्ट-केंद्रित एडिटिंग: दृश्य वस्तुओं पर क्लिक करके या टेक्स्ट निर्देशों का उपयोग करके विशिष्ट साउंड ईवेंट्स को परिष्कृत या संपादित करें।

- यूनिफाइड फ्रेमवर्क: एक फाउंडेशन मॉडल जेनरेशन, एडिटिंग और इंटरएक्टिव वर्कफ्लो को सपोर्ट करता है।

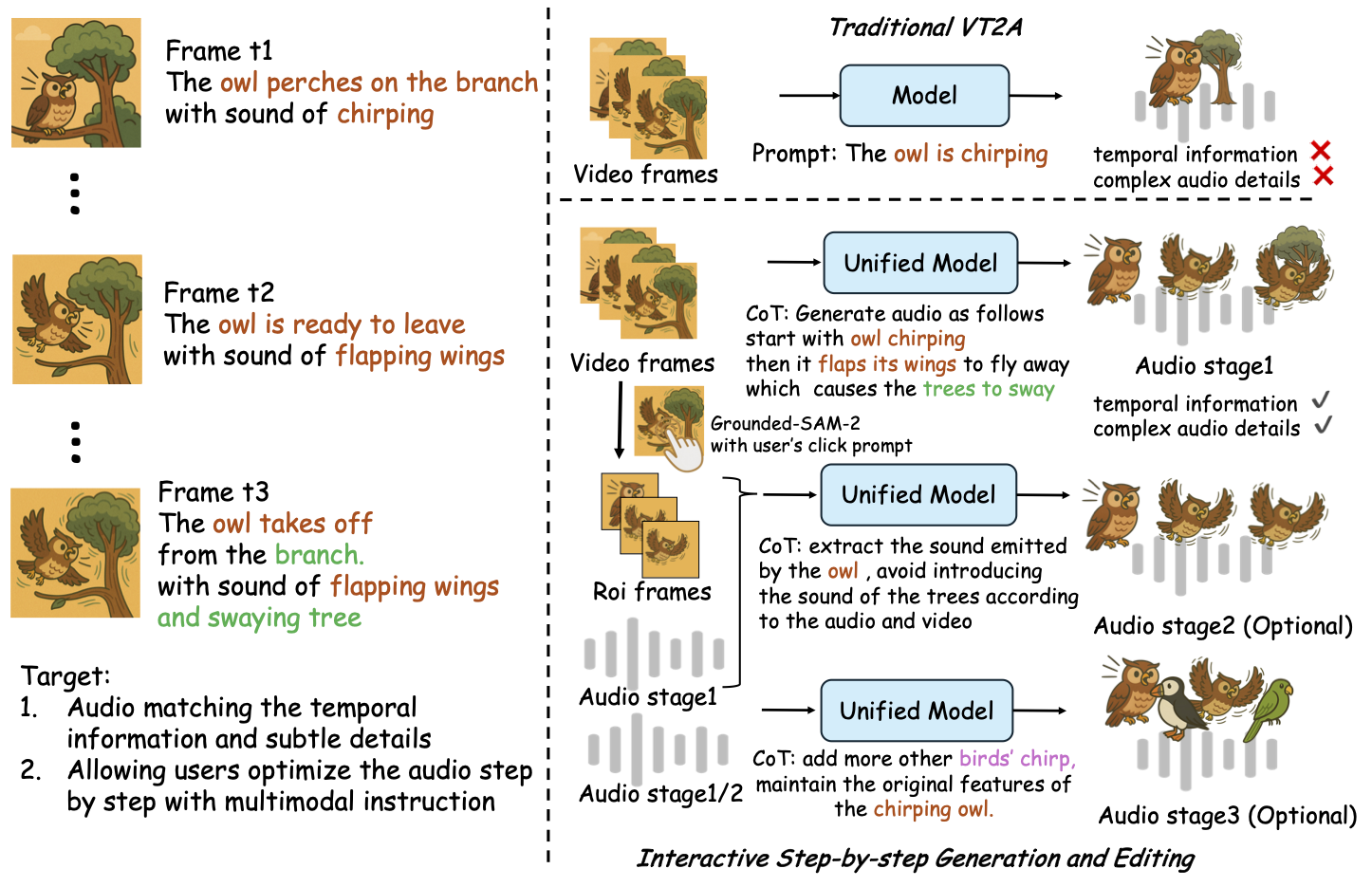

✨ विधि का अवलोकन

ThinkSound ऑडियो जनरेशन और एडिटिंग को तीन इंटरएक्टिव चरणों में विभाजित करता है, जो सभी MLLM-आधारित चेन-ऑफ-थॉट (CoT) रीजनिंग द्वारा निर्देशित होते हैं:

- फोली जेनरेशन: वीडियो से अर्थपूर्ण और समय-संरेखित आधारभूत साउंडस्केप्स जनरेट करें।

- ऑब्जेक्ट-केंद्रित परिष्करण: वीडियो में क्लिक या क्षेत्र द्वारा यूजर-निर्दिष्ट वस्तुओं के लिए ध्वनियों को परिष्कृत या जोड़ें।

- लक्षित ऑडियो संपादन: उच्च-स्तरीय प्राकृतिक भाषा निर्देशों का उपयोग करके जनरेटेड ऑडियो को संशोधित करें।

⚡ त्वरित शुरुआत

पर्यावरण तैयारी:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ Windows टिप:

Windows उपयोगकर्ता केवल setup_windows.bat चला सकते हैं (या उस पर डबल-क्लिक कर सकते हैं) जिससे कोंडा वातावरण अपने आप बन जाएगा, सभी आवश्यकताएँ (FFmpeg सहित) स्थापित हो जाएंगी, और प्रीट्रेंड मॉडल डाउनलोड हो जाएगा — कोई मैन्युअल सेटअप आवश्यक नहीं है।

स्क्रिप्ट चलाने से पहले सुनिश्चित करें कि आपके सिस्टम PATH मेंcondaऔरgitइंस्टॉल और उपलब्ध हैं।

▶️ डेमो चलाएँ

#### Linux/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>इसके बजाय आप प्रदान की गई <code>.bat</code> स्क्रिप्ट का उपयोग कर सकते हैं:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>नोट:</strong></p><ul><li><code><path-to-your-demo-video></code>: एकल वीडियो का पथ</li>

<li><code>[use-half]</code> (वैकल्पिक): अंतिम में use-half जोड़ें ताकि हाफ प्रिसीजन फीचर एक्सट्रैक्शन सक्षम हो सके।</li></p><p></ul>---</p><h3>📦 बैच इनफेरेंस</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>विंडोज़</strong></p><p>समान <code>.bat</code> स्क्रिप्ट का उपयोग करें:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>नोट:</strong></p><ul><li><code><video_path></code>: उस मूल निर्देशिका का पथ जिसमें सभी .mp4 वीडियो प्रोसेसिंग के लिए रखे गए हैं (सभी वीडियो की अवधि समान होनी चाहिए)।</li>

<li><code><csv_path></code>: प्रत्येक वीडियो के लिए टेक्स्ट प्रॉम्प्ट्स वाली एक CSV फ़ाइल (फॉर्मेट के लिए <code>demo_test.csv</code> देखें)।</li>

<li><code><save_path></code> (वैकल्पिक): जनरेटेड ऑडियो को कहाँ सेव करना है। डिफ़ॉल्ट है <code>results/features</code>।</li>

<li><code>[use-half]</code> (वैकल्पिक): हाफ प्रिसीजन फ़ीचर एक्सट्रैक्शन को सक्षम करने के लिए अंत में use-half जोड़ें।</li></p><p></ul>---</p><h3>वेब इंटरफेस उपयोग</h3></p><p>इंटरएक्टिव अनुभव के लिए, Gradio वेब इंटरफेस लॉन्च करें:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ मॉडल को प्रशिक्षित करें</h2></p><p>देखें <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 TODO और भविष्य की योजनाएँ</h2>

<ul><li>- [ ] एक अधिक शक्तिशाली फाउंडेशन मॉडल जारी करें जो कई क्षेत्रों को कवर करे ताकि अधिक आकर्षक और इमर्सिव फोली निर्माण प्रदान किया जा सके</li>

<li>- [ ] अतिरिक्त मोडालिटी और डाउनस्ट्रीम कार्यों के लिए समर्थन जोड़ें</li>

<li>- [ ] विभिन्न स्तरों पर मॉडल जारी करें</li>

<li>- [x] AudioCoT डेटासेट और स्वचालित पाइपलाइन को ओपन-सोर्स करें</li>

<li>- [x] ThinkSound मॉडल के लिए प्रशिक्षण स्क्रिप्ट जारी करें</li>

<li>- [x] शुरुआती के लिए Windows क्विक-स्टार्ट README जारी करें</li>

</ul>---</p><h2>📄 लाइसेंस</h2></p><p>यह परियोजना Apache 2.0 लाइसेंस के तहत जारी की गई है।</p><blockquote><strong>नोट:</strong></blockquote>

<blockquote>कोड, मॉडल, और डेटासेट <strong>केवल शोध और शैक्षिक उद्देश्यों के लिए हैं</strong>।</blockquote>

<blockquote><strong>व्यावसायिक उपयोग की अनुमति नहीं है।</strong></blockquote>

<blockquote>व्यावसायिक लाइसेंसिंग के लिए, कृपया लेखकों से संपर्क करें।</blockquote></p><p><strong>📦 तृतीय-पक्ष घटक</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (Stability AI द्वारा):</li>

</ul>यह रिपॉजिटरी <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a> से फाइन-ट्यून किया गया VAE शामिल करती है, जो <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">Stability AI Community License</a> के अंतर्गत लाइसेंस प्राप्त है।

<strong>व्यावसायिक उपयोग और पुनर्वितरण के लिए Stability AI से पूर्व अनुमति आवश्यक है।</strong></p><ul><li>📘 <strong>अन्य सभी कोड और मॉडल</strong> Apache License 2.0 के तहत जारी किए गए हैं।</li></p><p></ul>---</p><h2>आभार</h2></p><p>बहुत धन्यवाद:</p><ul><li><strong>stable-audio-tools</strong> (Stability AI द्वारा):</li>

</ul>ऑडियो जनरेशन के लिए आसान फ्रेमवर्क प्रदान करने के लिए, साथ ही VAE मॉड्यूल और वज़न के लिए।

<ul><li><strong>MMAudio</strong>:</li>

</ul>ऑडियो डोमेन में MM-DiT बैकबोन के कार्यान्वयन के लिए।</p><hr></p><h2>📖 उद्धरण</h2></p><p>यदि आपको ThinkSound अपने शोध या कार्य में उपयोगी लगे, तो कृपया हमारे पेपर का उल्लेख करें:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>