تینکساند

🌐 انگلیسی | 简体中文 | 繁體中文 | اسپانیایی | فرانسوی | ژاپنی

اگر این پروژه برای شما مفید بود،

یک ستاره ⭐ در گیتهاب بسیار ارزشمند خواهد بود!

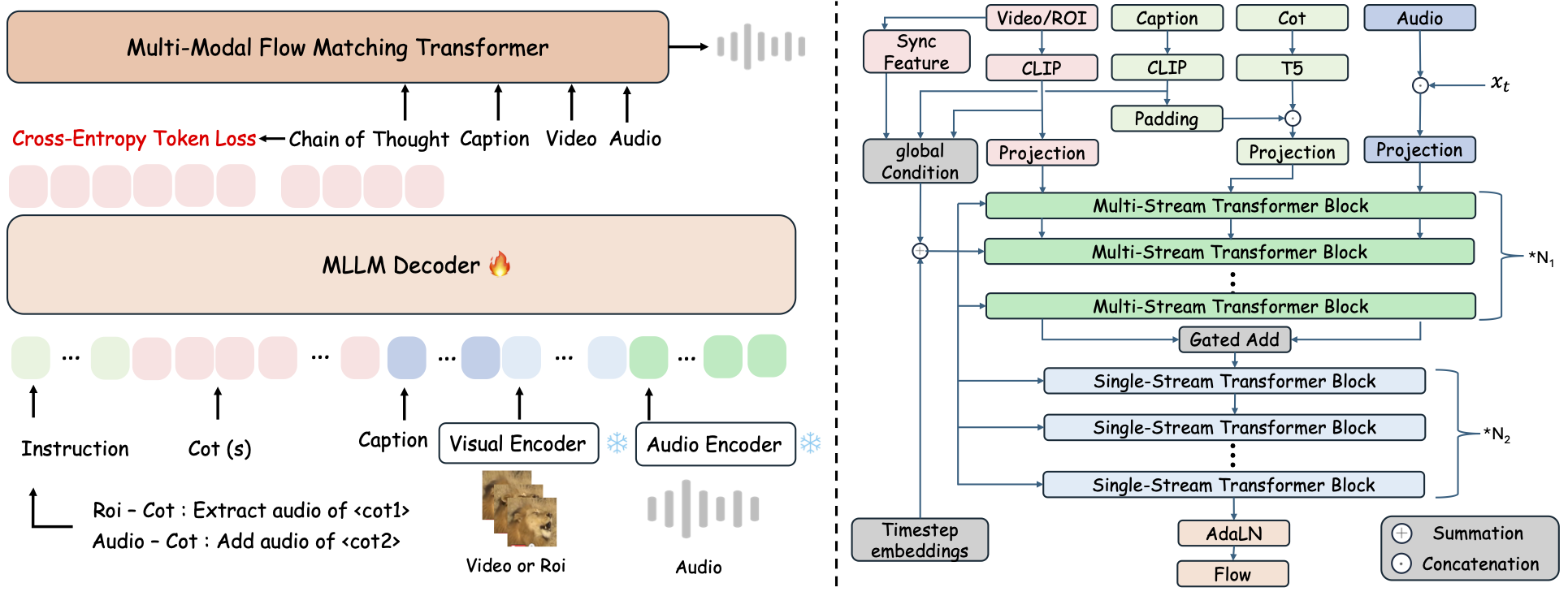

تینکساند یک چارچوب یکپارچه برای تولید Any2Audio است که با تطبیق جریان و راهنمایی استدلال زنجیرهای (CoT) هدایت میشود.

پیادهسازی PyTorch برای تولید و ویرایش چندحالته صوتی: تولید یا ویرایش صوت از ویدیو، متن و صوت، با استفاده از استدلال گامبهگام توسط مدلهای بزرگ زبانی چندحالته (MLLM).

📰 اخبار

- 2025.11.25 🔥دموی آنلاین PrismAudio فعال شد - همین حالا امتحان کنید!

- 2025.11.25 🔥مقاله PrismAudio در arXiv منتشر شد، اولین چارچوب چندبعدی CoT-RL برای تولید صوت از ویدیو!

- 2025.09.19 🎉 ThinkSound در کنفرانس اصلی NeurIPS 2025 پذیرفته شد!

- 2025.09.01 دیتاست AudioCoT اکنون متنباز بوده و در Hugging Face قابل دسترسی است!

- 2025.07.17 🧠 آموزش و ریزتنظیم فعال شد: کد آموزش و ریزتنظیم اکنون به صورت عمومی در دسترس است، همراه با راهنمای استفاده شفاف برای شخصیسازی و توسعه ThinkSound با دادههای خودتان.

- 2025.07.15 📦 نصب و استفاده سادهشده: وابستگیها در PyPI برای راهاندازی آسان بر روی همه پلتفرمها؛ اسکریپتهای ویندوز

.batبرای خودکارسازی ساخت محیط و اجرای اسکریپتها. - 2025.07.08 🔧 بهروزرسانی عمده: مدل سبکتر شده و مصرف حافظه و GPU بهینه شده، اکنون از تولید صوت با توان بالا در مقیاس وسیع پشتیبانی میکند!

- 2025.07.01 دموی آنلاین در Hugging Face Spaces و ModelScope برای تجربه تعاملی!

- 2025.07.01 اسکریپتهای استنتاج و رابط وب منتشر شد؛

- 2025.06 مقاله ThinkSound در arXiv منتشر شد!

- 2025.06 دموی آنلاین فعال شد - همین حالا امتحان کنید!

🚀 ویژگیها

- Any2Audio: تولید صوت از هر حالت دلخواه — ویدیو، متن، صوت یا ترکیب آنها.

- Video-to-Audio SOTA: دستیابی به نتایج پیشرو در چندین معیار V2A.

- استدلال مبتنی بر CoT: استدلال زنجیرهای برای تولید صوت ترکیبی و قابل کنترل از طریق MLLMها.

- ویرایش تعاملی مبتنی بر شیء: اصلاح یا ویرایش رویدادهای صوتی خاص با کلیک روی اشیاء بصری یا استفاده از دستورالعمل متنی.

- چارچوب یکپارچه: یک مدل پایه که از تولید، ویرایش و گردشکار تعاملی پشتیبانی میکند.

✨ مرور روش

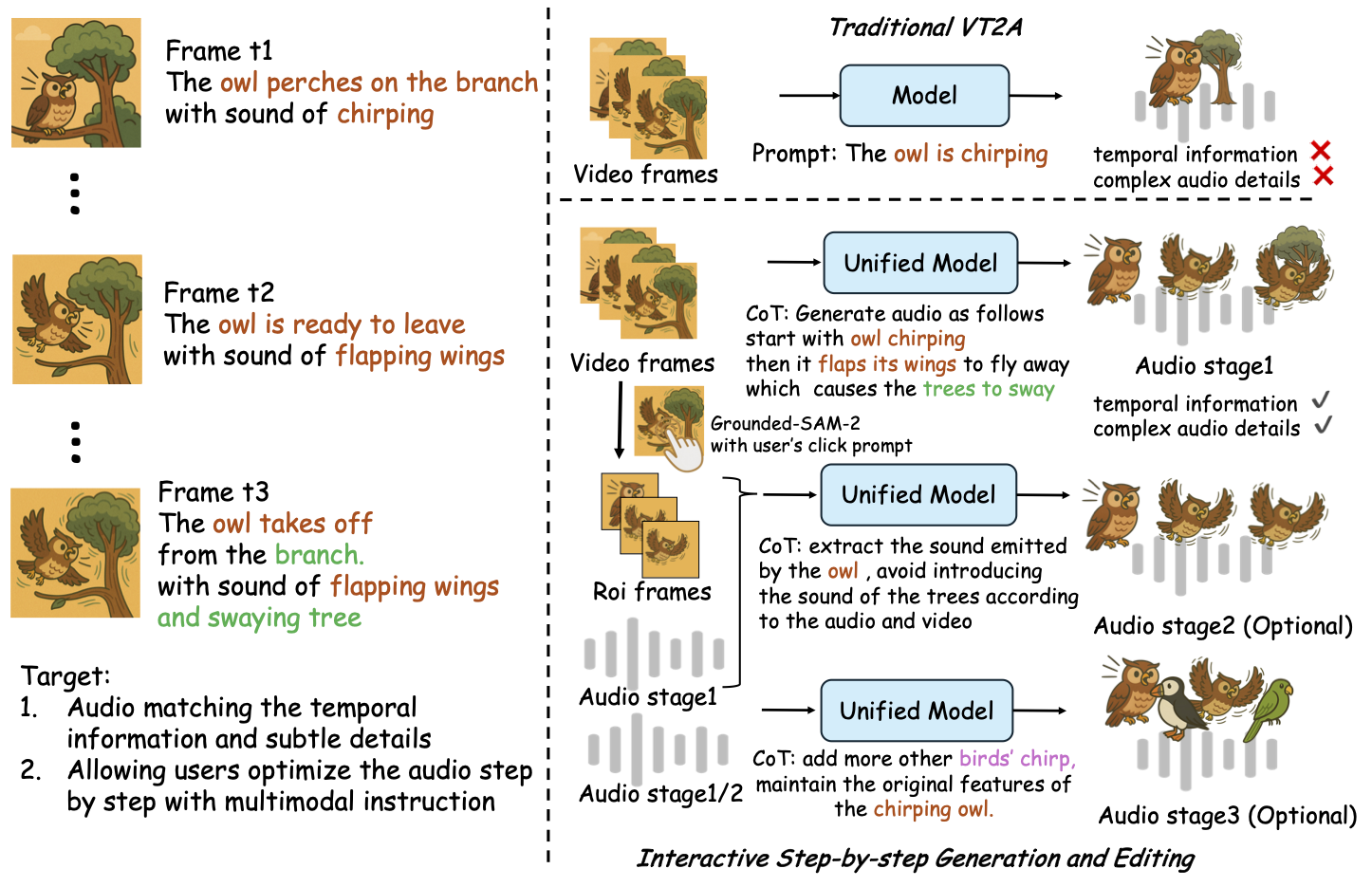

ThinkSound تولید و ویرایش صوت را به سه مرحله تعاملی تقسیم میکند که همگی با استدلال زنجیرهای مبتنی بر MLLM هدایت میشوند:

- تولید Foley: تولید صحنههای صوتی پایه با همترازی معنایی و زمانی از ویدیو.

- اصلاح مبتنی بر شیء: اصلاح یا افزودن صوت برای اشیاء مشخصشده توسط کاربر از طریق کلیک یا ناحیه در ویدیو.

- ویرایش هدفمند صوت: تغییر صوت تولیدشده با استفاده از دستورالعملهای زبان طبیعی سطح بالا.

⚡ شروع سریع

آمادهسازی محیط:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ نکته ویندوز:

کاربران ویندوز میتوانند به سادگی فایل setup_windows.bat را اجرا کنند (یا روی آن دوبار کلیک کنند) تا محیط کاندا بهطور خودکار ساخته شود، تمامی وابستگیها (از جمله FFmpeg) نصب شوند و مدل از پیش آموزشدیده دانلود گردد — هیچ تنظیمات دستی لازم نیست.

قبل از اجرای اسکریپت، مطمئن شوید کهcondaوgitنصب شده و در PATH سیستم شما قرار دارند.

▶️ اجرای دمو

#### لینوکس/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>ویندوز</strong></p><p>در عوض میتوانید از اسکریپت <code>.bat</code> ارائهشده استفاده کنید:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>توجه:</strong></p><ul><li><code><path-to-your-demo-video></code>: مسیر یک ویدئوی تکی</li>

<li><code>[use-half]</code> (اختیاری): افزودن use-half در انتها برای فعالسازی استخراج ویژگی با دقت نیمه.</li></p><p></ul>---</p><h3>📦 استنتاج دستهای</h3></p><p>#### <strong>لینوکس/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>ویندوز</strong></p><p>از اسکریپت معادل <code>.bat</code> استفاده کنید:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>توجه:</strong></p><ul><li><code><video_path></code>: مسیر دایرکتوری اصلی که حاوی تمام ویدیوهای .mp4 برای پردازش است (همه ویدیوها باید مدت زمان یکسان داشته باشند).</li>

<li><code><csv_path></code>: یک فایل CSV با متون راهنما برای هر ویدیو (فرمت را در <code>demo_test.csv</code> ببینید).</li>

<li><code><save_path></code> (اختیاری): مسیر ذخیرهسازی فایلهای صوتی تولید شده. به طور پیشفرض <code>results/features</code> است.</li>

<li><code>[use-half]</code> (اختیاری): افزودن use-half در انتها برای فعالسازی استخراج ویژگی با دقت نیمه.</li></p><p></ul>---</p><h3>استفاده از رابط وب</h3></p><p>برای تجربه تعاملی، رابط وب Gradio را اجرا کنید:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ آموزش مدل</h2></p><p>به <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a> مراجعه کنید.</p><hr></p><h2>📝 برنامههای آینده و کارهای باقیمانده</h2>

<ul><li>- [ ] انتشار یک مدل پایه قدرتمندتر که چندین حوزه را پوشش دهد و خلق فولی جذابتر و فراگیرتری ارائه کند</li>

<li>- [ ] افزودن پشتیبانی از حالتهای بیشتر و وظایف پاییندستی</li>

<li>- [ ] انتشار مدلها در مقیاسهای مختلف</li>

<li>- [x] متنباز کردن مجموعه داده AudioCoT و خط لوله خودکار</li>

<li>- [x] انتشار اسکریپتهای آموزش برای مدلهای ThinkSound</li>

<li>- [x] README شروع سریع برای ویندوز مناسب مبتدیان</li>

</ul>---</p><h2>📄 مجوز</h2></p><p>این پروژه تحت مجوز Apache 2.0 منتشر شده است.</p><blockquote><strong>توجه:</strong></blockquote>

<blockquote>کد، مدلها و مجموعه داده <strong>فقط برای اهداف پژوهشی و آموزشی</strong> هستند.</blockquote>

<blockquote><strong>استفاده تجاری مجاز نیست.</strong></blockquote>

<blockquote>برای اخذ مجوز تجاری، لطفاً با نویسندگان تماس بگیرید.</blockquote></p><p><strong>📦 اجزای شخص ثالث</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (توسط Stability AI):</li>

</ul>این مخزن شامل یک VAE تنظیمشده از <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a> است که تحت <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">مجوز Stability AI Community License</a> ارائه شده است.

<strong>استفاده و توزیع تجاری نیازمند اخذ مجوز قبلی از Stability AI است.</strong></p><ul><li>📘 <strong>سایر کدها و مدلها</strong> تحت مجوز Apache License 2.0 منتشر شدهاند.</li></p><p></ul>---</p><h2>تقدیر و تشکر</h2></p><p>با تشکر فراوان از:</p><ul><li><strong>stable-audio-tools</strong> (توسط Stability AI):</li>

</ul>برای ارائه یک چارچوب آسان برای تولید صوت، همچنین ماژول VAE و وزنها.

<ul><li><strong>MMAudio</strong>:</li>

</ul>برای پیادهسازی ستون فقرات MM-DiT در حوزه صوت.</p><hr></p><h2>📖 ارجاع</h2></p><p>اگر ThinkSound در تحقیقات یا کار شما مفید بود، لطفاً مقاله ما را ارجاع دهید:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>