ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

Si encuentras útil este proyecto,

¡un estrella ⭐ en GitHub sería muy apreciado!

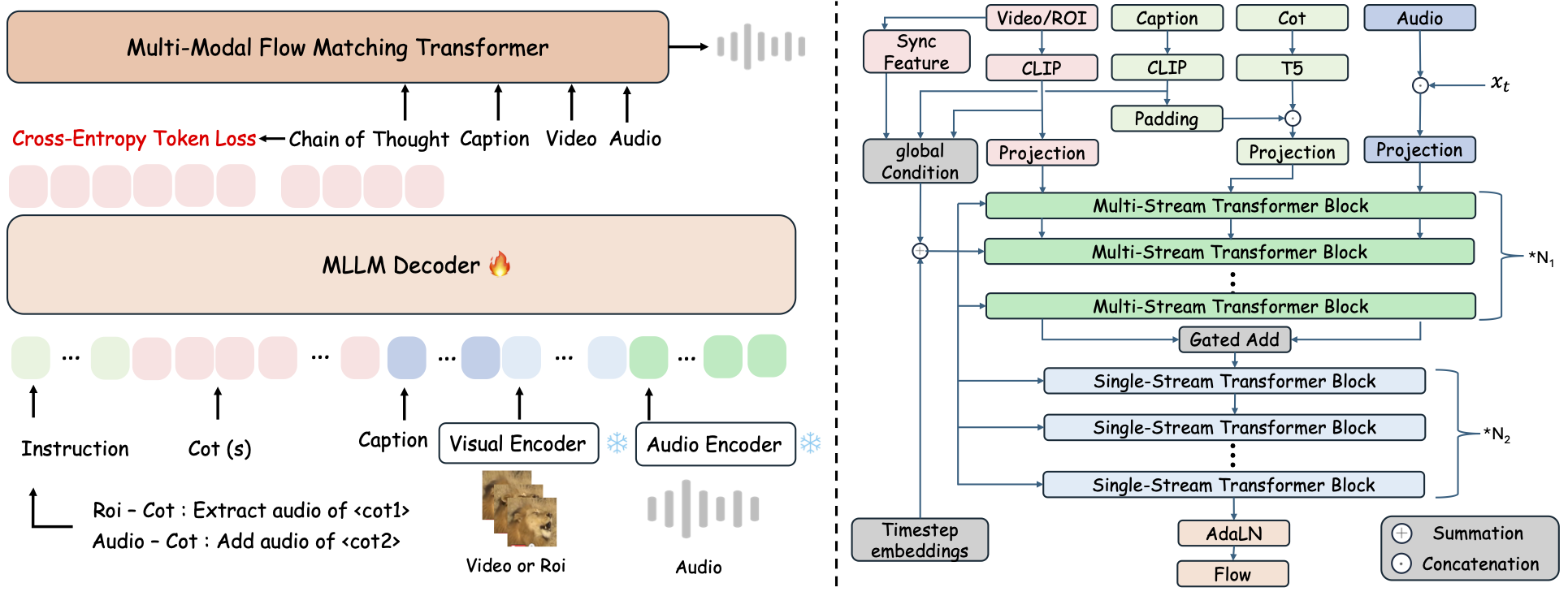

ThinkSound es un marco unificado de generación Any2Audio con coincidencia de flujo guiada por razonamiento de Cadena de Pensamiento (CoT). Implementación en PyTorch para generación y edición de audio multimodal: genera o edita audio a partir de video, texto y audio, impulsado por razonamiento paso a paso de Modelos de Lenguaje Multimodal de Gran Escala (MLLMs).

📰 Noticias

- 2025.11.25 🔥Demo en línea de PrismAudio disponible - ¡pruébalo ahora!

- 2025.11.25 🔥Artículo de PrismAudio publicado en arXiv, ¡el primer marco CoT-RL multidimensional para generación de audio desde video!

- 2025.09.19 🎉 ThinkSound ha sido aceptado en la Conferencia Principal de NeurIPS 2025!

- 2025.09.01 Nuestro conjunto de datos AudioCoT ya es de código abierto y está disponible en Hugging Face!

- 2025.07.17 🧠 Finetuning habilitado: código para entrenamiento y ajuste fino ahora disponible públicamente, junto con instrucciones claras para ayudarte a personalizar y ampliar ThinkSound con tus propios datos.

- 2025.07.15 📦 Instalación y usabilidad simplificadas: dependencias en PyPI para fácil configuración multiplataforma; scripts

.batde Windows automatizan la creación de entornos y ejecución de scripts. - 2025.07.08 🔧 Actualización mayor: modelo aligerado y optimizado en uso de memoria y GPU, ¡ahora soporta generación de audio de alto rendimiento a escala!

- 2025.07.01 Demo en línea en Hugging Face Spaces y ModelScope para experiencia interactiva!

- 2025.07.01 Scripts de inferencia y la interfaz web publicados;

- 2025.06 Artículo de ThinkSound publicado en arXiv!

- 2025.06 Demo en línea disponible - ¡pruébalo ahora!

🚀 Características

- Any2Audio: Genera audio a partir de modalidades arbitrarias — video, texto, audio o sus combinaciones.

- Video-a-Audio SOTA: Logra resultados de última generación en múltiples benchmarks V2A.

- Razonamiento impulsado por CoT: Razonamiento de Cadena de Pensamientos para generación de audio composicional y controlable a través de MLLMs.

- Edición interactiva centrada en objetos: Refina o edita eventos sonoros específicos haciendo clic en objetos visuales o usando instrucciones de texto.

- Marco unificado: Un modelo base soporta generación, edición y flujo de trabajo interactivo.

✨ Resumen del Método

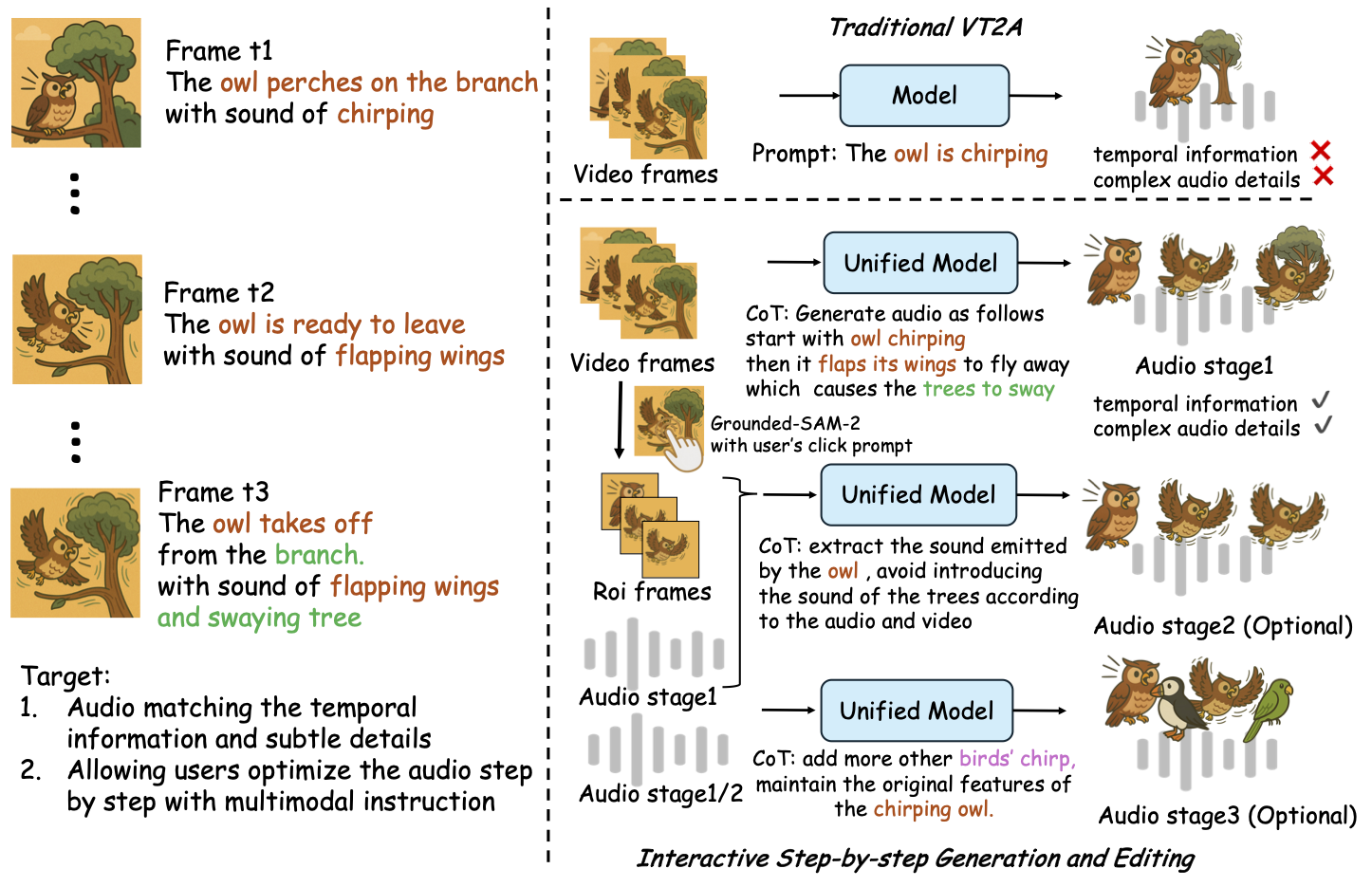

ThinkSound descompone la generación y edición de audio en tres etapas interactivas, todas guiadas por razonamiento CoT basado en MLLM:

- Generación Foley: Genera paisajes sonoros fundamentales, alineados semántica y temporalmente a partir de video.

- Refinamiento centrado en objetos: Refina o añade sonidos para objetos especificados por el usuario mediante clics o regiones en el video.

- Edición de audio dirigida: Modifica el audio generado usando instrucciones de lenguaje natural de alto nivel.

⚡ Inicio Rápido

Preparación del entorno:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ Consejo para Windows:

Los usuarios de Windows pueden simplemente ejecutar setup_windows.bat (o hacer doble clic en él) para crear automáticamente el entorno conda, instalar todas las dependencias (incluido FFmpeg) y descargar el modelo preentrenado — no se requiere configuración manual.

Asegúrate de quecondaygitestén instalados y disponibles en el PATH de tu sistema antes de ejecutar el script.

▶️ Ejecutar la Demostración

#### Linux/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>En su lugar, puede usar el script <code>.bat</code> proporcionado:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>Nota:</strong></p><ul><li><code><ruta-a-tu-video-demo></code>: La ruta a un solo video</li>

<li><code>[use-half]</code> (opcional): Añade use-half al final para habilitar la extracción de características en media precisión.</li></p><p></ul>---</p><h3>📦 Inferencia por Lotes</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Utilice el script <code>.bat</code> equivalente:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>Nota:</strong></p><ul><li><code><video_path></code>: Ruta al directorio raíz que contiene todos los videos .mp4 a procesar (todos los videos deben tener la misma duración).</li>

<li><code><csv_path></code>: Un archivo CSV con indicaciones de texto para cada video (ver <code>demo_test.csv</code> para el formato).</li>

<li><code><save_path></code> (opcional): Dónde guardar el audio generado. Por defecto es <code>results/features</code>.</li>

<li><code>[use-half]</code> (opcional): Agregue use-half al final para habilitar la extracción de características en precisión media.</li></p><p></ul>---</p><h3>Uso de la Interfaz Web</h3></p><p>Para una experiencia interactiva, inicie la interfaz web de Gradio:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ Entrena el Modelo</h2></p><p>Consulta <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 TODO y Planes Futuros</h2>

<ul><li>- [ ] Lanzar un modelo base más potente que cubra múltiples dominios para ofrecer una creación de foley más atractiva e inmersiva</li>

<li>- [ ] Agregar soporte para modalidades adicionales y tareas posteriores</li>

<li>- [ ] Lanzar modelos en diferentes escalas</li>

<li>- [x] Liberar el conjunto de datos AudioCoT y la canalización automatizada como código abierto</li>

<li>- [x] Publicar scripts de entrenamiento para los modelos ThinkSound</li>

<li>- [x] Un README de inicio rápido para Windows, amigable para principiantes</li>

</ul>---</p><h2>📄 Licencia</h2></p><p>Este proyecto se publica bajo la Licencia Apache 2.0.</p><blockquote><strong>Nota:</strong></blockquote>

<blockquote>El código, los modelos y el conjunto de datos son <strong>solo para fines de investigación y educativos</strong>.</blockquote>

<blockquote><strong>NO se permite el uso comercial.</strong></blockquote>

<blockquote>Para licencias comerciales, por favor contacte a los autores.</blockquote></p><p><strong>📦 Componentes de Terceros</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (por Stability AI):</li>

</ul>Este repositorio incluye un VAE ajustado de <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a>, licenciado bajo la <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">Licencia Comunitaria de Stability AI</a>.

<strong>El uso comercial y la redistribución requieren permiso previo de Stability AI.</strong></p><ul><li>📘 <strong>Todo el resto del código y modelos</strong> se publica bajo la Licencia Apache 2.0.</li></p><p></ul>---</p><h2>Agradecimientos</h2></p><p>Muchas gracias a:</p><ul><li><strong>stable-audio-tools</strong> (por Stability AI):</li>

</ul>Por proporcionar un marco fácil de usar para la generación de audio, así como el módulo VAE y sus pesos.

<ul><li><strong>MMAudio</strong>:</li>

</ul>Por la implementación del backbone MM-DiT en el dominio de audio.</p><hr></p><h2>📖 Citación</h2></p><p>Si ThinkSound te resulta útil en tu investigación o trabajo, por favor cita nuestro artículo:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>