ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

Wenn Sie dieses Projekt nützlich finden,

würden wir uns sehr über einen Stern ⭐ auf GitHub freuen!

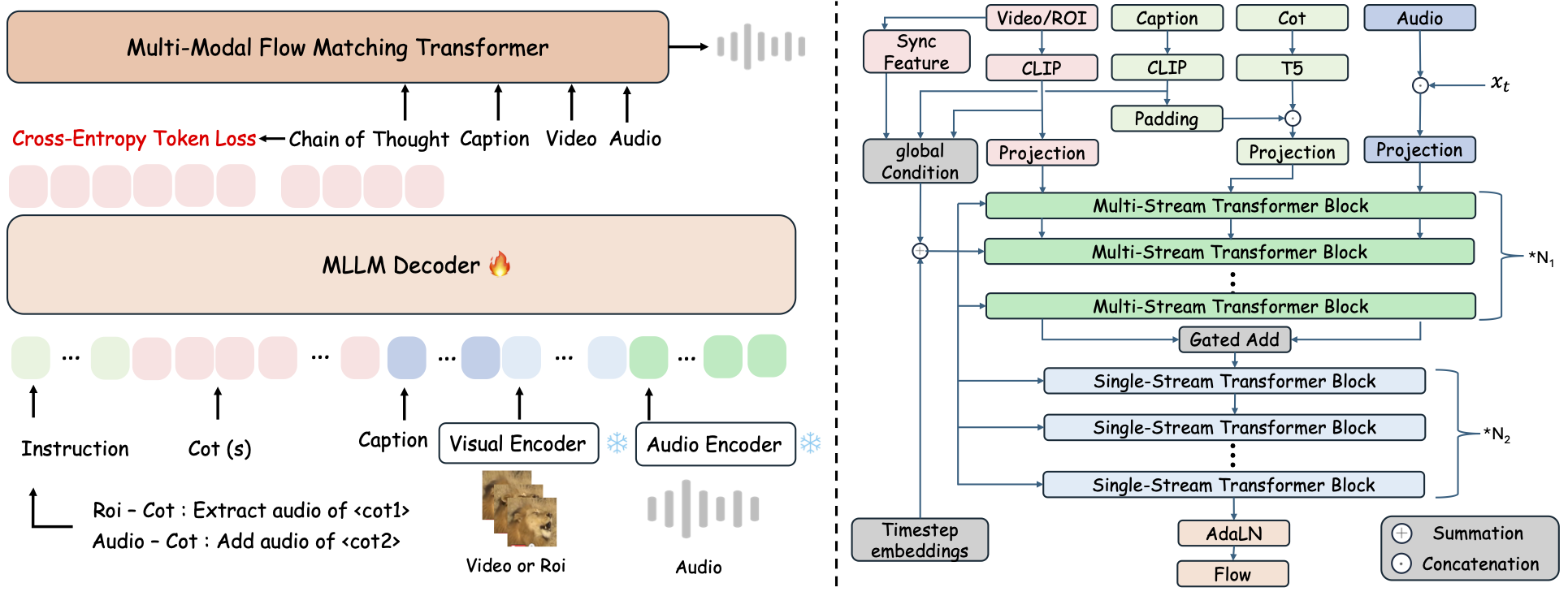

ThinkSound ist ein einheitliches Any2Audio-Generierungsframework mit Flow Matching, das durch Chain-of-Thought (CoT)-Reasoning gesteuert wird.

PyTorch-Implementierung für multimodale Audiogenerierung und -bearbeitung: Erstellen oder Bearbeiten von Audio aus Video, Text und Audio, unterstützt durch schrittweise Argumentation von Multimodalen Großen Sprachmodellen (MLLMs).

📰 Neuigkeiten

- 2025.11.25 🔥Online PrismAudio Demo ist live – jetzt ausprobieren!

- 2025.11.25 🔥PrismAudio Paper veröffentlicht auf arXiv, das erste multidimensionale CoT-RL-Framework für Video-zu-Audio-Generierung!

- 2025.09.19 🎉 ThinkSound wurde auf der NeurIPS 2025 Hauptkonferenz angenommen!

- 2025.09.01 Unser AudioCoT-Datensatz ist jetzt quelloffen und auf Hugging Face verfügbar!

- 2025.07.17 🧠 Finetuning aktiviert: Trainings- und Finetuning-Code ist jetzt öffentlich verfügbar, mit klaren Anweisungen zur individuellen Anpassung und Erweiterung von ThinkSound mit eigenen Daten.

- 2025.07.15 📦 Vereinfachte Installation und Benutzerfreundlichkeit: Abhängigkeiten auf PyPI für einfache plattformübergreifende Einrichtung; Windows-

.bat-Skripte automatisieren die Erstellung von Umgebungen und das Ausführen von Skripten. - 2025.07.08 🔧 Großes Update: Modell verschlankt und optimierter Speicher- sowie GPU-Verbrauch, unterstützt jetzt hochskalierbare Audiogenerierung!

- 2025.07.01 Online-Demo auf Hugging Face Spaces und ModelScope für interaktive Erfahrungen!

- 2025.07.01 Veröffentlichte Inferenz-Skripte und Weboberfläche;

- 2025.06 ThinkSound Paper auf arXiv erschienen!

- 2025.06 Online-Demo ist live – jetzt ausprobieren!

🚀 Funktionen

- Any2Audio: Generiere Audio aus beliebigen Modalitäten – Video, Text, Audio oder deren Kombinationen.

- Video-zu-Audio SOTA: Erzielt State-of-the-Art-Ergebnisse auf mehreren V2A-Benchmarks.

- CoT-gesteuertes Reasoning: Chain-of-Thought-Reasoning für kompositionelle und steuerbare Audiogenerierung über MLLMs.

- Interaktive objektzentrierte Bearbeitung: Verfeinere oder bearbeite spezifische Klangereignisse durch Klicken auf visuelle Objekte oder mit Textanweisungen.

- Einheitliches Framework: Ein Grundmodell unterstützt Generierung, Bearbeitung und interaktiven Workflow.

✨ Methodenüberblick

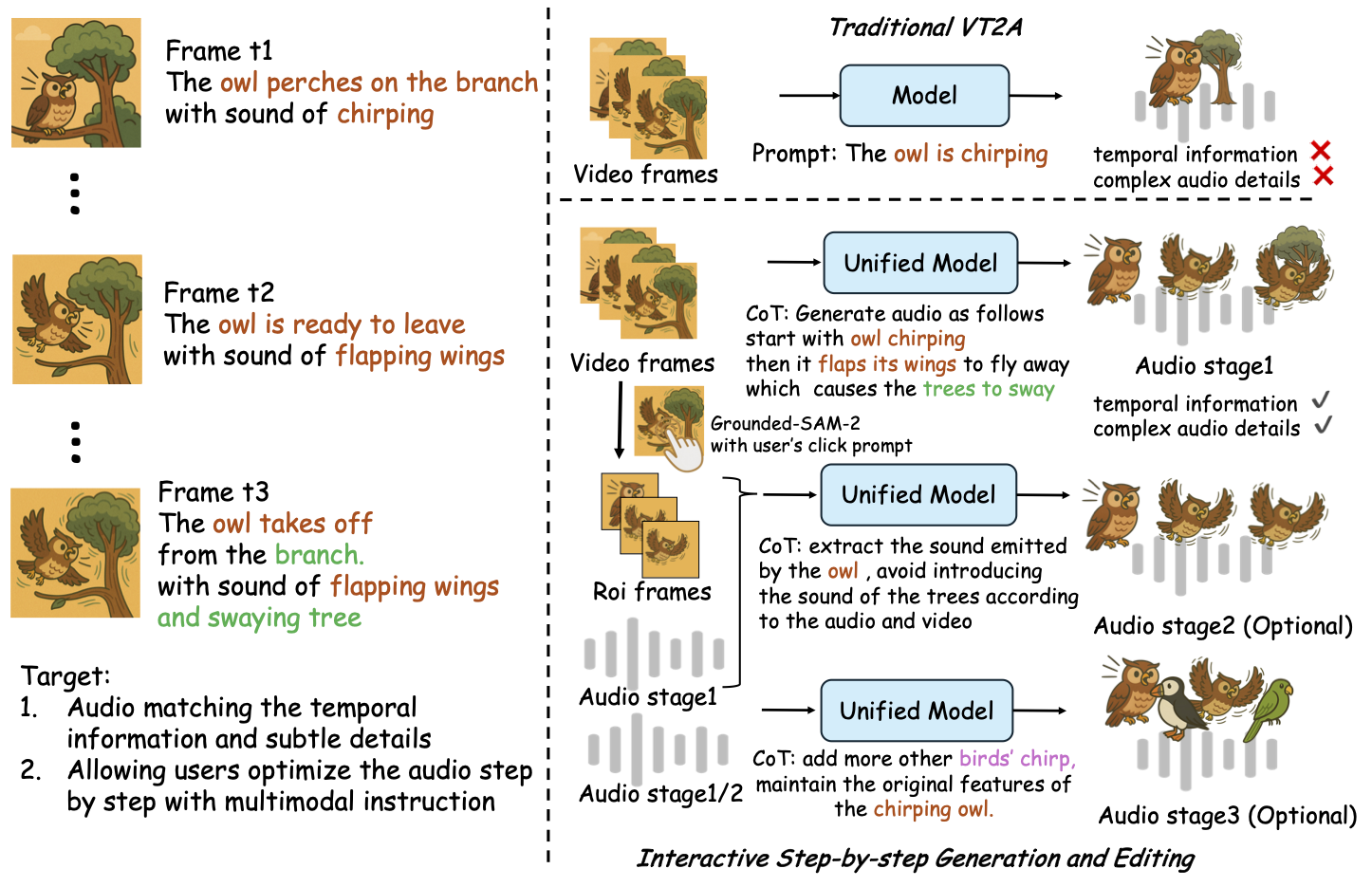

ThinkSound unterteilt Audiogenerierung und -bearbeitung in drei interaktive Phasen, alle gesteuert durch MLLM-basiertes Chain-of-Thought (CoT)-Reasoning:

- Foley-Generierung: Erzeuge grundlegende, semantisch und zeitlich ausgerichtete Klanglandschaften aus Video.

- Objektzentrierte Verfeinerung: Verfeinere oder füge Klänge für benutzerspezifizierte Objekte durch Klicks oder Regionen im Video hinzu.

- Gezielte Audiobearbeitung: Modifiziere generiertes Audio mit hochrangigen natürlichen Sprachinstruktionen.

⚡ Schnellstart

Umgebungsvorbereitung:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ Windows-Tipp:

Windows-Benutzer können einfach setup_windows.bat ausführen (oder doppelt anklicken), um automatisch die Conda-Umgebung zu erstellen, alle Abhängigkeiten zu installieren (einschließlich FFmpeg) und das vortrainierte Modell herunterzuladen — keine manuelle Einrichtung erforderlich.

Stellen Sie sicher, dasscondaundgitinstalliert sind und sich in Ihrem System-PATH befinden, bevor Sie das Skript ausführen.

▶️ Demo ausführen

#### Linux/macOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Stattdessen können Sie das bereitgestellte <code>.bat</code>-Skript verwenden:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>Hinweis:</strong></p><ul><li><code><path-to-your-demo-video></code>: Der Pfad zu einem einzelnen Video</li>

<li><code>[use-half]</code> (optional): Fügen Sie use-half am Ende hinzu, um die Extraktion von Merkmalen mit halber Genauigkeit zu aktivieren.</li></p><p></ul>---</p><h3>📦 Stapel-Inferenz</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>Windows</strong></p><p>Verwenden Sie das entsprechende <code>.bat</code>-Skript:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>Hinweis:</strong></p><ul><li><code><video_path></code>: Pfad zum Stammverzeichnis, das alle zu verarbeitenden .mp4-Videos enthält (alle Videos müssen die gleiche Dauer haben).</li>

<li><code><csv_path></code>: Eine CSV-Datei mit Text-Inputs für jedes Video (siehe <code>demo_test.csv</code> für das Format).</li>

<li><code><save_path></code> (optional): Speicherort für die generierte Audiodatei. Standardmäßig <code>results/features</code>.</li>

<li><code>[use-half]</code> (optional): Fügen Sie use-half am Ende hinzu, um die Halbpräzisions-Feature-Extraktion zu aktivieren.</li></p><p></ul>---</p><h3>Nutzung der Weboberfläche</h3></p><p>Für eine interaktive Erfahrung starten Sie die Gradio-Weboberfläche:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ Modell trainieren</h2></p><p>Siehe <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 TODO & Zukunftspläne</h2>

<ul><li>- [ ] Veröffentlichung eines leistungsfähigeren Foundation-Modells für mehrere Domänen zur Bereitstellung einer ansprechenderen und immersiveren Foley-Erstellung</li>

<li>- [ ] Unterstützung für zusätzliche Modalitäten und nachgelagerte Aufgaben hinzufügen</li>

<li>- [ ] Veröffentlichung von Modellen in verschiedenen Größen</li>

<li>- [x] Open-Source AudioCoT-Datensatz und automatisierte Pipeline</li>

<li>- [x] Veröffentlichung von Trainingsskripten für ThinkSound-Modelle</li>

<li>- [x] Ein einsteigerfreundliches Windows-Quickstart-README</li>

</ul>---</p><h2>📄 Lizenz</h2></p><p>Dieses Projekt wird unter der Apache 2.0 Lizenz veröffentlicht.</p><blockquote><strong>Hinweis:</strong></blockquote>

<blockquote>Der Code, die Modelle und der Datensatz sind <strong>ausschließlich für Forschungs- und Bildungszwecke</strong>.</blockquote>

<blockquote><strong>Kommerzielle Nutzung ist NICHT gestattet.</strong></blockquote>

<blockquote>Für kommerzielle Lizenzen kontaktieren Sie bitte die Autoren.</blockquote></p><p><strong>📦 Komponenten Dritter</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (von Stability AI):</li>

</ul>Dieses Repository enthält ein feinabgestimmtes VAE von <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a>, lizenziert unter der <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">Stability AI Community License</a>.

<strong>Kommerzielle Nutzung und Weiterverteilung erfordern vorherige Genehmigung durch Stability AI.</strong></p><ul><li>📘 <strong>Alle anderen Codes und Modelle</strong> sind unter der Apache License 2.0 veröffentlicht.</li></p><p></ul>---</p><h2>Danksagungen</h2></p><p>Vielen Dank an:</p><ul><li><strong>stable-audio-tools</strong> (von Stability AI):</li>

</ul>Für die Bereitstellung eines benutzerfreundlichen Frameworks zur Audiogenerierung sowie des VAE-Moduls und der Gewichte.

<ul><li><strong>MMAudio</strong>:</li>

</ul>Für die Implementierung des MM-DiT-Backbones im Audio-Bereich.</p><hr></p><h2>📖 Zitation</h2></p><p>Wenn ThinkSound für Ihre Forschung oder Arbeit nützlich ist, zitieren Sie bitte unser Paper:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>