ThinkSound

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

যদি আপুনি এই প্ৰকল্পটো উপকাৰী বুলি ভাবেন,

GitHub-ত এটা ষ্টাৰ ⭐ দিয়া অতি মূল্যবান হ'ব!

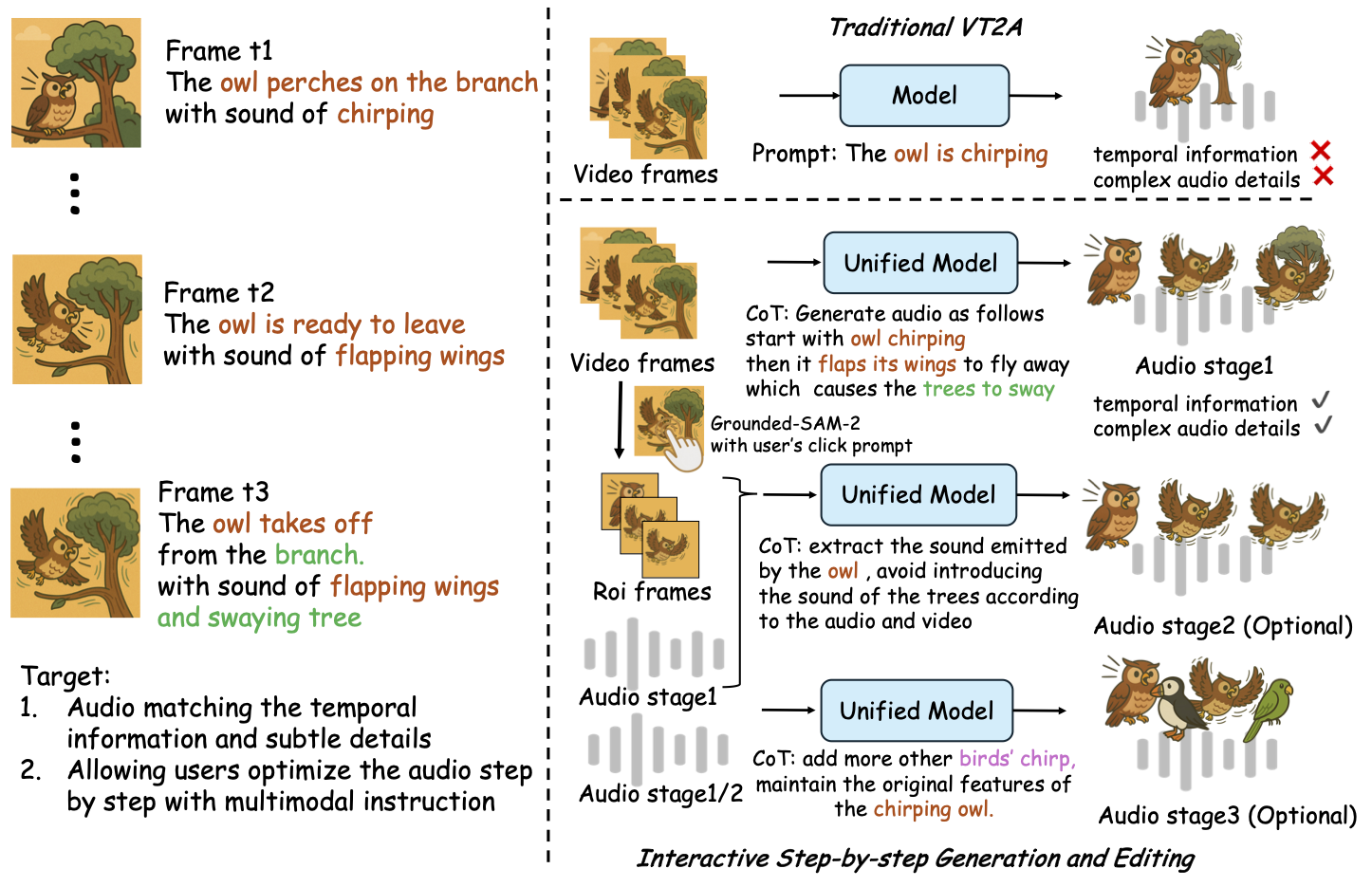

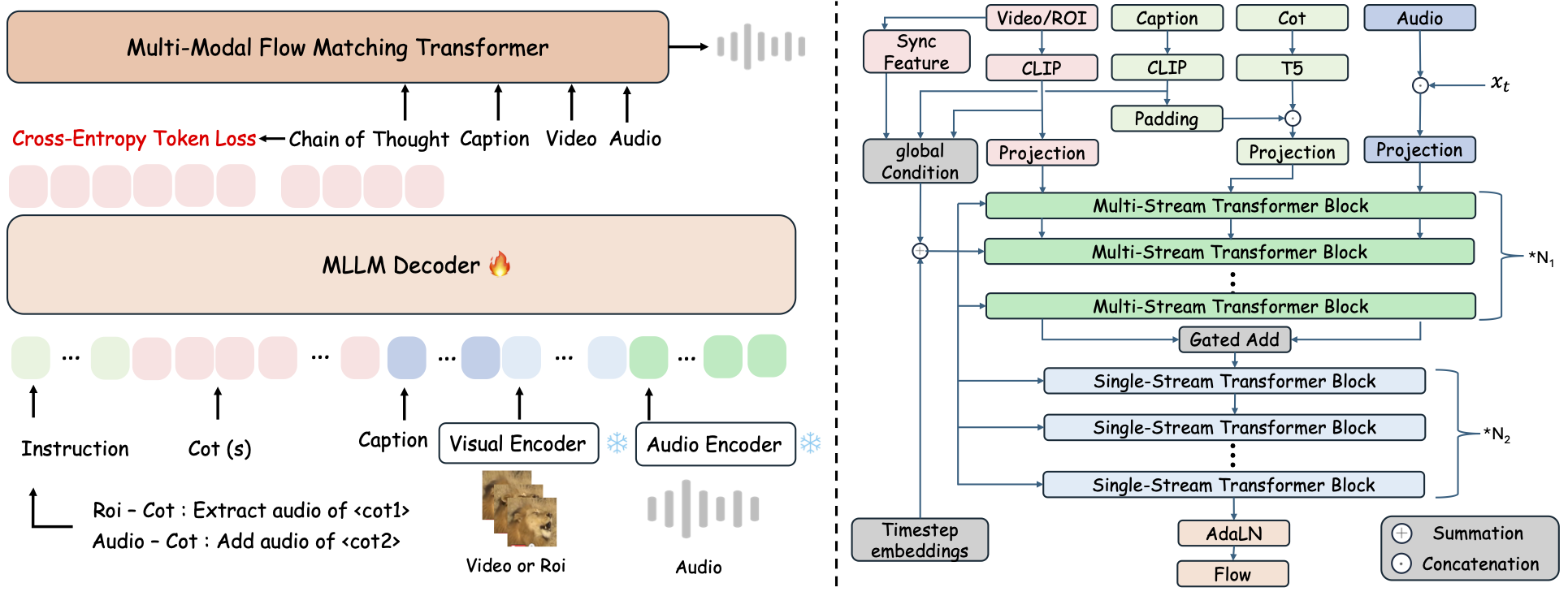

ThinkSound হৈছে এটা একত্ৰ Any2Audio উৎপাদন ফ্ৰেমৱৰ্ক যি Flow Matching-Chain-of-Thought (CoT) reasoning-এৰে পথ পৰিচালনা কৰে।

মাল্টিম'ডেল অডিঅ' জেনাৰেচন আৰু সম্পাদনাৰ বাবে PyTorch ৰূপায়ণ: ভিডিঅ', পাঠ্য, আৰু অডিঅ'ৰ পৰা অডিঅ' উত্পন্ন কৰক বা সম্পাদনা কৰক, Multimodal Large Language Models (MLLMs) ৰ ধাপ-ধাপে যুক্তিবাদ দ্বাৰা শক্তিশালী।

📰 বাতৰি

- ২০২৫.১১.২৫ 🔥অনলাইন PrismAudio ডেমো উপলব্ধ - এতিয়াই চেষ্টা কৰক!

- ২০২৫.১১.২৫ 🔥PrismAudio কাগজ arXiv-ত মুক্তি, Video-to-Audio Generation-ৰ বাবে প্ৰথম বহু-মাত্ৰিক CoT-RL ফ্ৰেমৱৰ্ক!

- ২০২৫.০৯.১৯ 🎉 ThinkSound NeurIPS 2025 মুখ্য সম্মেলন-ত গ্ৰহণ কৰা হৈছে!

- ২০২৫.০৯.০১ আমাৰ AudioCoT ডেটাছেট এতিয়া মুক্ত-উৎস আৰু Hugging Face-ত উপলব্ধ!

- ২০২৫.০৭.১৭ 🧠 ফাইনটিউনিং সক্ৰিয়: প্ৰশিক্ষণ আৰু ফাইনটিউনিং কোড এতিয়া পাবলিক, স্পষ্ট ব্যৱহাৰ নিৰ্দেশনা সহ ThinkSound আপোনাৰ নিজৰ ডেটাৰে কাষ্টমাইজ আৰু বিস্তৃত কৰিবলৈ।

- ২০২৫.০৭.১৫ 📦 সহজ ইনস্টলেশ্বন আৰু ব্যৱহাৰযোগ্যতা: PyPI-ৰ ওপৰত নির্ভরতাবোৰে সহজ cross-platform ছেটআপ; Windows

.batস্ক্ৰিপ্টে পৰিৱেশ সৃষ্টি আৰু স্ক্ৰিপ্ট চলোৱা স্বয়ংক্ৰিয় কৰে। - ২০২৫.০৭.০৮ 🔧 ডাঙৰ আপডেট: মডেল হালকা আৰু মেম'ৰি আৰু GPU ব্যৱহাৰ অনুকূলিত, এতিয়া উচ্চ-থ্ৰুপুট অডিঅ' জেনাৰেচন স্কেলত সমৰ্থিত!

- ২০২৫.০৭.০১ অনলাইন ডেমো Hugging Face Spaces আৰু ModelScope-ত ইন্টাৰেক্টিভ অভিজ্ঞতাৰ বাবে!

- ২০২৫.০৭.০১ ইনফাৰেন্স স্ক্ৰিপ্ট আৰু ৱেব ইন্টাৰফেচ মুক্তি;

- ২০২৫.০৬ ThinkSound কাগজ arXiv-ত মুক্তি!

- ২০২৫.০৬ অনলাইন ডেমো উপলব্ধ - এতিয়াই চেষ্টা কৰক!

🚀 বৈশিষ্ট্যসমূহ

- Any2Audio: যিকোনো মডালিটিৰ পৰা অডিঅ' উত্পন্ন কৰক — ভিডিঅ', পাঠ্য, অডিঅ', বা সিঙ্গতি।

- Video-to-Audio SOTA: বহুবিধ V2A বেঞ্চমাৰ্কত state-of-the-art ফলাফল লাভ কৰে।

- CoT-Driven Reasoning: MLLMs-ৰ মাধ্যমে সংযোজিত আৰু নিয়ন্ত্ৰণযোগ্য অডিঅ' জেনাৰেচনৰ বাবে Chain-of-Thought যুক্তিবাদ।

- Interactive Object-centric Editing: দৃশ্যমান অবজেক্টত ক্লিক বা পাঠ্য নিৰ্দেশনা ব্যৱহাৰ কৰি নিৰ্দিষ্ট শব্দ ঘটনাসমূহ সংশোধন বা সম্পাদনা কৰক।

- Unified Framework: এটা মৌলিক মডেলে জেনাৰেচন, সম্পাদনা, আৰু ইন্টাৰেক্টিভ ৱৰ্কফ্লো সমৰ্থন কৰে।

✨ পদ্ধতিৰ সংক্ষিপ্তসাৰ

ThinkSound-এ অডিঅ' জেনাৰেচন আৰু সম্পাদনাক তিনিটা ইন্টাৰেক্টিভ পৰ্যায়ত বিভক্ত কৰে, সকলো MLLM-ভিত্তিক Chain-of-Thought (CoT) যুক্তিবাদ দ্বাৰা নিৰ্দেশিত:

- Foley Generation: ভিডিঅ'-ৰ পৰা মৌলিক, অৰ্থবহ আৰু কালানুক্ৰমিকভাৱে মিলিত শব্দ সৃষ্টি কৰক।

- Object-Centric Refinement: ভিডিঅ'ত ক্লিক বা অঞ্চলসমূহৰ মাধ্যমে ব্যৱহাৰকাৰী নিৰ্দিষ্ট অবজেক্টৰ বাবে শব্দ সংশোধন বা যোগ কৰক।

- Targeted Audio Editing: উচ্চ-স্তৰৰ প্ৰাকৃতিক ভাষা নিৰ্দেশনা ব্যৱহাৰ কৰি উত্পন্ন অডিঅ' সম্পাদনা কৰক।

⚡ তৎক্ষণাত আৰম্ভ কৰক

পৰিবেশ প্ৰস্তুতি:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ উইণ্ড'জ টিপ:

উইণ্ড'জ ব্যৱহাৰকাৰীসকলে সহজে setup_windows.bat চলাব পাৰে (অথবা ইয়াত ডাবল-ক্লিক কৰিব পাৰে) যাতে স্বয়ংক্ৰিয়ভাৱে কন্ডা পৰিৱেশ সৃষ্টি হয়, সকলো নিৰ্ভৰতা (FFmpeg সহ) সংস্থাপন হয়, আৰু প্ৰি-ট্ৰেইনড মডেল ডাউনলোড হয় — কোনো হস্তচালিত সংস্থাপন প্ৰয়োজন নহয়।

স্ক্ৰিপ্ট চলোৱাৰ আগতে আপোনাৰ ব্যৱস্থাতcondaআৰুgitসংস্থাপন কৰা আৰু PATH-ত উপলব্ধ হোৱা নিশ্চিত কৰক।

▶️ ডেম’ চলাওক

#### লিনাক্স/ম্যাক’এস

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre></p><p>#### <strong>Windows</strong></p><p>আপুনি ইয়াৰ বিপৰীতে প্ৰদান কৰা <code>.bat</code> স্ক্ৰিপ্ট ব্যৱহাৰ কৰিব পাৰে:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre></p><p><strong>টোকা:</strong></p><ul><li><code><path-to-your-demo-video></code>: এটা ভিডিঅ'ৰ পথ</li>

<li><code>[use-half]</code> (ঐচ্ছিক): আধা প্ৰেছিছন বৈশিষ্ট্য এক্সট্ৰাকশ্যন সক্ৰিয় কৰিবলৈ শেষত use-half যোগ কৰক।</li></p><p></ul>---</p><h3>📦 বেটচ ইনফাৰেন্স</h3></p><p>#### <strong>Linux/macOS</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre></p><p>#### <strong>উইণ্ডোজ</strong></p><p>সমান <code>.bat</code> স্ক্ৰিপ্ট ব্যৱহাৰ কৰক:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre></p><p><strong>টোকা:</strong></p><ul><li><code><video_path></code>: প্ৰক্ৰিয়া কৰিবলৈ সকলো .mp4 ভিডিঅ' থকা মূল ডাইৰেক্টৰীৰ পথ (সকলো ভিডিঅ'ৰ সময়সীমা সমান হ'ব লাগিব).</li>

<li><code><csv_path></code>: প্ৰত্যেক ভিডিঅ'ৰ বাবে টেক্সট প্ৰম্পট থকা এটা CSV ফাইল (<code>demo_test.csv</code>ত ফৰ্মেট চাওক).</li>

<li><code><save_path></code> (ঐচ্ছিক): নিৰ্মিত অডিঅ' সংৰক্ষণ কৰাৰ স্থান. ডিফল্ট <code>results/features</code>।</li>

<li><code>[use-half]</code> (ঐচ্ছিক): আধা প্ৰিসিশন ফিচাৰ এক্সট্ৰাকচন সক্ৰিয় কৰিবলৈ শেষত use-half যোগ কৰক।</li></p><p></ul>---</p><h3>ৱেব ইণ্টাৰফেছ ব্যৱহাৰ</h3></p><p>ইন্টাৰেক্টিভ অভিজ্ঞতাৰ বাবে, Gradio ৱেব ইণ্টাৰফেছ আৰম্ভ কৰক:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ মডেলটো প্ৰশিক্ষণ দিয়ক</h2></p><p>চাওক <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 TODO আৰু ভবিষ্যতৰ পৰিকল্পনা</h2>

<ul><li>- [ ] বহুতো ক্ষেত্ৰত অধিক শক্তিশালী ফাউণ্ডেশ্যন মডেল মুক্তি দিয়ক, যাতে অধিক আকৰ্ষণীয় আৰু ডুব দিয়া ফoley সৃষ্টি কৰিব পাৰি</li>

<li>- [ ] অতিৰিক্ত মোডালিটী আৰু ডাউনস্ট্ৰিম টাস্ক সমৰ্থন যোগ কৰক</li>

<li>- [ ] ভিন্ন স্কেলত মডেল মুক্তি দিয়ক</li>

<li>- [x] AudioCoT ডেটাসেট আৰু স্বচালিত পাইপলাইন ওপেন-ছৰ্চ কৰক</li>

<li>- [x] ThinkSound মডেলৰ প্ৰশিক্ষণ স্ক্ৰিপ্ট মুক্তি দিয়ক</li>

<li>- [x] আৰম্ভনিবাহী Windows কুইক-স্টাৰ্ট README</li>

</ul>---</p><h2>📄 অনুমতি পত্ৰ</h2></p><p>এই প্ৰকল্পটো Apache 2.0 License অধীনত মুক্তি কৰা হৈছে।</p><blockquote><strong>টোকা:</strong></blockquote>

<blockquote>কোড, মডেল আৰু ডেটাসেট <strong>গৱেষণা আৰু শিক্ষা উদ্দেশ্যৰ বাবে</strong>।</blockquote>

<blockquote><strong>ব্যৱসায়িক ব্যৱহাৰ অনুমোদিত নহয়।</strong></blockquote>

<blockquote>ব্যৱসায়িক অনুমতিৰ বাবে, অনুগ্ৰহ কৰি লেখকসকলৰ সৈতে যোগাযোগ কৰক।</blockquote></p><p><strong>📦 তৃতীয় পক্ষৰ উপাদানসমূহ</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (Stability AI দ্বাৰা):</li>

</ul>এই ৰিপ'জিটৰিটোত <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a> ৰ পৰা ফাইন-টিউন কৰা VAE অন্তর্ভুক্ত আছে, যি <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">Stability AI Community License</a> অধীনত লাইসেন্স কৰা হৈছে।

<strong>ব্যৱসায়িক ব্যৱহাৰ আৰু পুনৰ্বিতৰণৰ বাবে Stability AI ৰ পূৰ্ব অনুমতি আৱশ্যক।</strong></p><ul><li>📘 <strong>বাকী সকলো কোড আৰু মডেল</strong> Apache License 2.0 অধীনত মুক্তি কৰা হৈছে।</li></p><p></ul>---</p><h2>কৃতজ্ঞতা</h2></p><p>ধন্যবাদ জ্ঞাপন:</p><ul><li><strong>stable-audio-tools</strong> (Stability AI দ্বাৰা):</li>

</ul>অডিঅ' প্ৰজন্মৰ বাবে সহজ ব্যৱহাৰযোগ্য ফ্ৰেমৱৰ্ক, লগতে VAE মডিউল আৰু ৱেইট উপলব্ধ কৰোৱাৰ বাবে।

<ul><li><strong>MMAudio</strong>:</li>

</ul>অডিঅ' ক্ষেত্ৰত MM-DiT বেকব'নৰ ৰূপায়ণৰ বাবে।</p><hr></p><h2>📖 উদ্ধৃতি</h2></p><p>যদি আপুনি ThinkSound আপোনাৰ গৱেষণা বা কামত সহায়ক বুলি পোৱা যায়, অনুগ্ৰহ কৰি আমাৰ প্ৰবন্ধ উদ্ধৃত কৰক:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>