ثينك ساوند

🌐 English | 简体中文 | 繁體中文 | Español | Français | 日本語

إذا وجدت هذا المشروع مفيدًا،

سيكون من الرائع وضع نجمة ⭐ على GitHub!

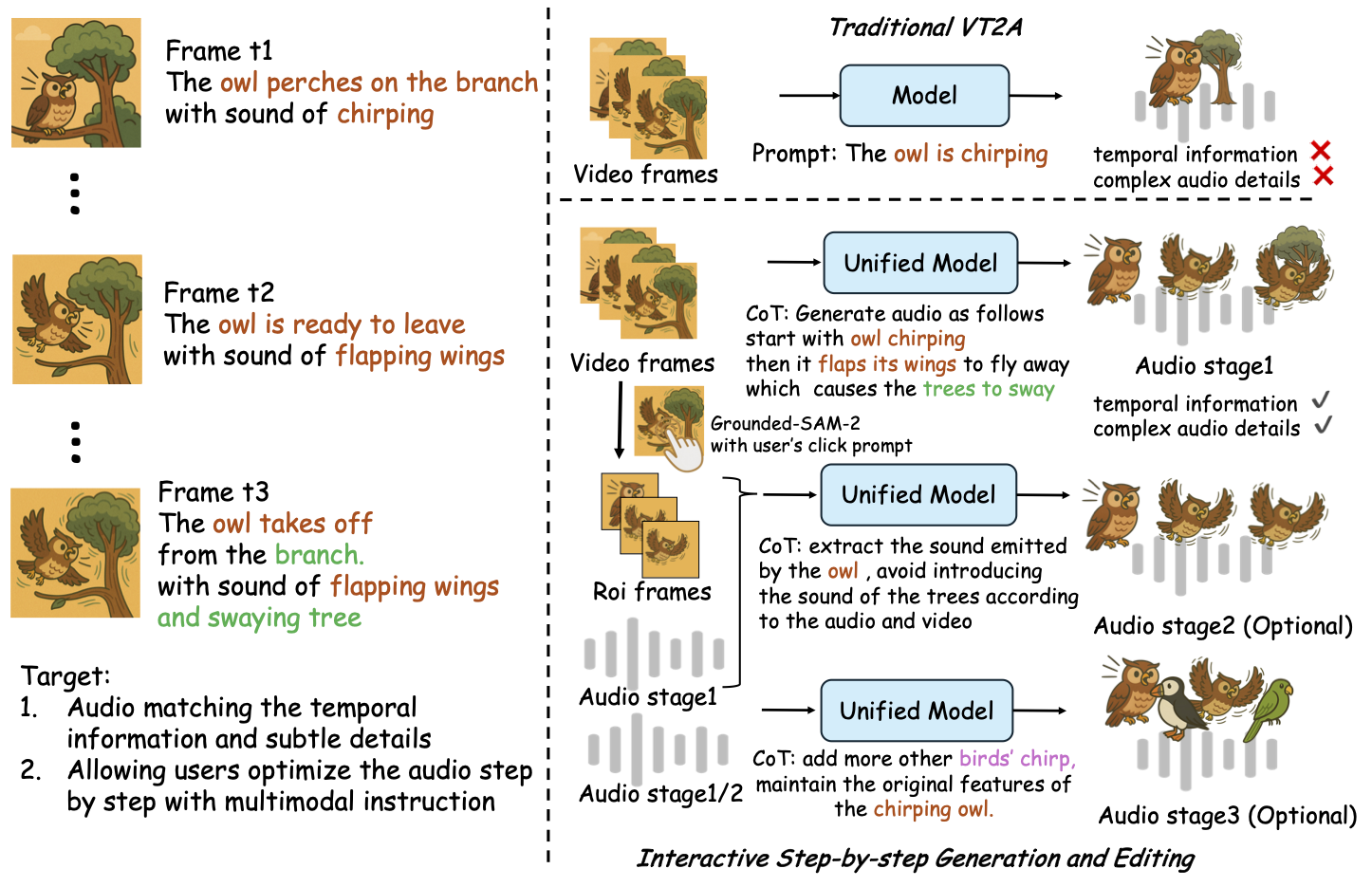

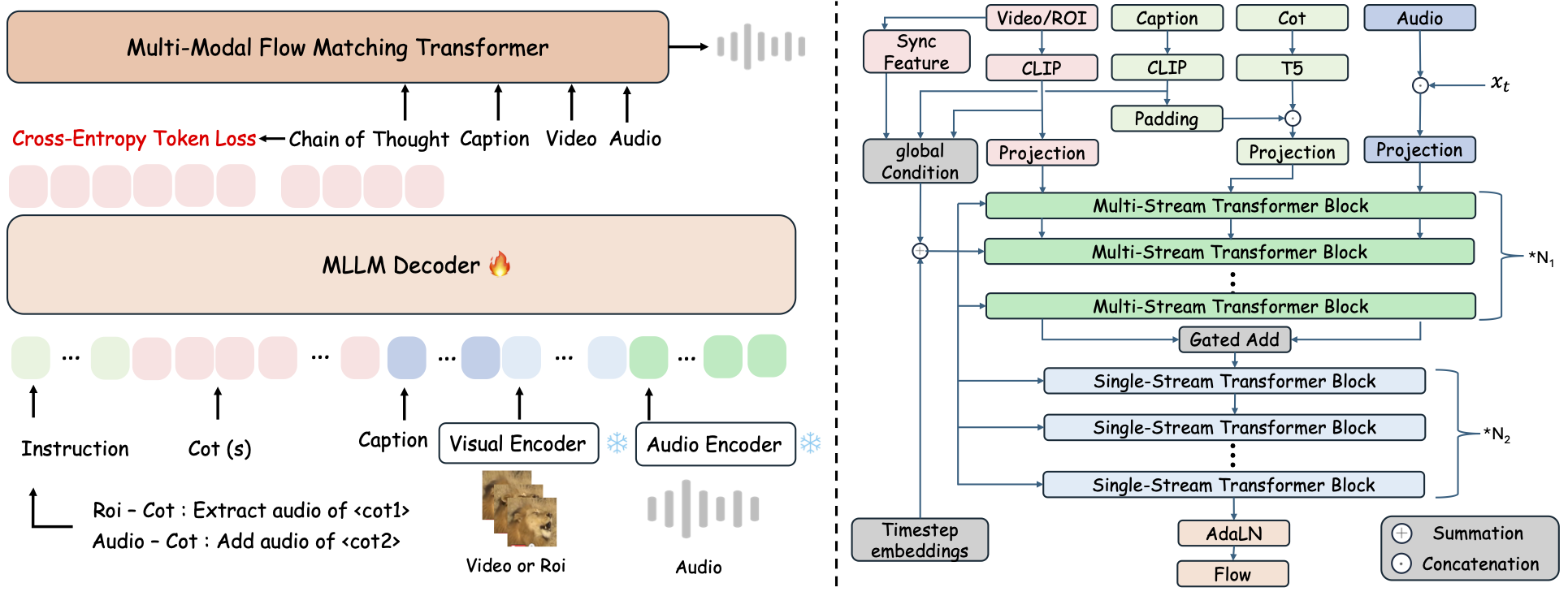

ثينك ساوند هو إطار موحد لتوليد الصوت من أي مدخلات (Any2Audio) باستخدام مطابقة التدفق الموجهة بواسطة استدلال سلسلة الأفكار (CoT). تنفيذ PyTorch لتوليد وتحرير الصوت متعدد الوسائط: توليد أو تحرير الصوت من الفيديو أو النص أو الصوت، مدعوم بخطوات تفكير متسلسلة من نماذج اللغة الكبيرة متعددة الوسائط (MLLMs).

📰 الأخبار

- 2025.11.25 🔥عرض PrismAudio التجريبي المباشر متوفر الآن - جربه الآن!

- 2025.11.25 🔥ورقة PrismAudio صدرت على arXiv، أول إطار CoT-RL متعدد الأبعاد لتوليد الصوت من الفيديو!

- 2025.09.19 🎉 تم قبول ThinkSound في المؤتمر الرئيسي NeurIPS 2025!

- 2025.09.01 مجموعة بيانات AudioCoT مفتوحة المصدر ومتاحة الآن على Hugging Face!

- 2025.07.17 🧠 تفعيل التخصيص: الشيفرات الخاصة بالتدريب والتخصيص متاحة الآن مع تعليمات واضحة لمساعدتك على تخصيص وتوسيع ThinkSound ببياناتك الخاصة.

- 2025.07.15 📦 تبسيط التثبيت وسهولة الاستخدام: الاعتماديات متوفرة على PyPI لإعداد عبر الأنظمة بسهولة؛ سكريبتات Windows

.batلأتمتة إنشاء البيئة وتشغيل السكريبتات. - 2025.07.08 🔧 تحديث رئيسي: تم تخفيف وزن النموذج وتحسين استخدام الذاكرة ومعالج الرسوميات، يدعم الآن توليد صوت عالي الإنتاجية على نطاق واسع!

- 2025.07.01 عرض تجريبي مباشر على Hugging Face Spaces و ModelScope لتجربة تفاعلية!

- 2025.07.01 إصدار سكريبتات الاستدلال وواجهة الويب؛

- 2025.06 ورقة ThinkSound صدرت على arXiv!

- 2025.06 العرض التجريبي المباشر متوفر الآن - جربه الآن!

🚀 الميزات

- Any2Audio: توليد الصوت من أي نوع من الوسائط — فيديو أو نص أو صوت أو مزيج منها.

- الريادة في تحويل الفيديو إلى صوت: يحقق نتائج متقدمة على العديد من معايير V2A.

- تفكير مدفوع بسلسلة التفكير: توليد صوت تركيبي وتحكمي مدفوع بسلسلة التفكير عبر MLLMs.

- تحرير تفاعلي مركز على الكائنات: تنقيح أو تحرير أحداث صوتية محددة بالنقر على كائنات مرئية أو باستخدام تعليمات نصية.

- إطار موحد: نموذج أساسي واحد يدعم التوليد والتحرير وسير العمل التفاعلي.

✨ نظرة عامة على الطريقة

يقوم ThinkSound بتقسيم توليد وتحرير الصوت إلى ثلاث مراحل تفاعلية، جميعها موجهة بتفكير سلسلة التفكير المعتمد على MLLM:

- توليد Foley: إنشاء مشاهد صوتية أساسية متوافقة دلالياً وزمنياً مع الفيديو.

- تنقيح مركز على الكائنات: تنقيح أو إضافة أصوات لكائنات يحددها المستخدم عبر النقر أو تحديد مناطق في الفيديو.

- تحرير صوتي موجه: تعديل الصوت الناتج باستخدام تعليمات لغة طبيعية عالية المستوى.

⚡ البداية السريعة

تحضير البيئة:

git clone https://github.com/liuhuadai/ThinkSound.git

cd ThinkSound

conda create -n thinksound python=3.10

conda activate thinksound

pip install thinksound

conda install -y -c conda-forge 'ffmpeg<7'

Download pretrained weights https://huggingface.co/liuhuadai/ThinkSound to Directory ckpts/

model weights can be also downloaded from https://www.modelscope.cn/models/iic/ThinkSound

git lfs install

git clone https://huggingface.co/liuhuadai/ThinkSound ckpts

To improve inference and training speed, you may optionally install a FlashAttention backend compatible with your system and PyTorch version.

✅ نصيحة لمستخدمي ويندوز:

يمكن لمستخدمي ويندوز ببساطة تشغيل setup_windows.bat (أو النقر المزدوج عليه) لإنشاء بيئة conda تلقائيًا، وتثبيت جميع التبعيات (بما في ذلك FFmpeg)، وتنزيل النموذج المدرب مسبقًا — دون الحاجة للإعداد اليدوي.

تأكد من أنcondaوgitمثبتان ومتوفران في متغير PATH الخاص بالنظام قبل تشغيل السكربت.

▶️ تشغيل العرض التجريبي

#### لينكس/ماكOS

chmod +x scripts/demo.sh

./scripts/demo.sh <CoT description> [use-half]</code></pre>

#### <strong>ويندوز</strong></p><p>يمكنك بدلاً من ذلك استخدام البرنامج النصي <code>.bat</code> المرفق:</p><pre><code class="language-bash">.\scripts\demo.bat <path-to-your-demo-video> <title> <CoT description> [use-half]</code></pre>

<strong>ملاحظة:</strong></p><ul><li><code><مسار-فيديو-العرض-التوضيحي-الخاص-بك></code>: مسار فيديو واحد</li>

<li><code>[use-half]</code> (اختياري): أضف use-half في النهاية لتفعيل استخراج الميزات بدقة نصفية.</li></p><p></ul>---</p><h3>📦 الاستدلال على دفعات</h3></p><p>#### <strong>لينكس/ماك أو إس</strong></p><pre><code class="language-bash">chmod +x scripts/eval_batch.sh

./scripts/eval_batch.sh <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

#### <strong>ويندوز</strong></p><p>استخدم سكربت <code>.bat</code> المكافئ:</p><pre><code class="language-bash">.\scripts\eval_batch.bat <video_path> <csv_path> <save_path (optional)> [use-half]</code></pre>

<strong>ملاحظة:</strong></p><ul><li><code><video_path></code>: مسار الدليل الجذري الذي يحتوي على جميع ملفات الفيديو .mp4 المراد معالجتها (يجب أن تكون جميع الفيديوهات بنفس المدة).</li>

<li><code><csv_path></code>: ملف CSV يحتوي على مطالبات نصية لكل فيديو (انظر <code>demo_test.csv</code> لمعرفة التنسيق).</li>

<li><code><save_path></code> (اختياري): مكان حفظ الصوت الناتج. الافتراضي هو <code>results/features</code>.</li>

<li><code>[use-half]</code> (اختياري): أضف use-half في النهاية لتمكين استخراج الميزات بنصف الدقة.</li></p><p></ul>---</p><h3>استخدام الواجهة الويب</h3></p><p>للحصول على تجربة تفاعلية، قم بتشغيل واجهة Gradio على الويب:</p><pre><code class="language-bash">python app.py</code></pre></p><h2>🏋️ تدريب النموذج</h2></p><p>راجع <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/docs/Training.md" target="_blank" rel="noopener noreferrer"><code>Training.md</code></a></p><hr></p><h2>📝 المهام المستقبلية وخطط العمل</h2>

<ul><li>- [ ] إصدار نموذج أساسي أكثر قوة يغطي مجالات متعددة لتوفير إنشاء فولي أكثر جاذبية وانغماسًا</li>

<li>- [ ] إضافة دعم لأنماط إضافية ومهام لاحقة</li>

<li>- [ ] إصدار نماذج بمقاييس مختلفة</li>

<li>- [x] فتح مصدر مجموعة بيانات AudioCoT وخط الأنابيب المؤتمت</li>

<li>- [x] إصدار نصوص التدريب لنماذج ThinkSound</li>

<li>- [x] ملف README للبدء السريع في ويندوز للمبتدئين</li>

</ul>---</p><h2>📄 الترخيص</h2></p><p>تم إصدار هذا المشروع بموجب ترخيص أباتشي 2.0.</p><blockquote><strong>ملاحظة:</strong></blockquote>

<blockquote>الكود، النماذج، ومجموعة البيانات <strong>لأغراض البحث والتعليم فقط</strong>.</blockquote>

<blockquote><strong>الاستخدام التجاري غير مسموح به.</strong></blockquote>

<blockquote>للحصول على ترخيص تجاري، يرجى التواصل مع المؤلفين.</blockquote></p><p><strong>📦 المكونات الخارجية</strong></p><ul><li><strong>Stable Audio Open VAE</strong> (بواسطة Stability AI):</li>

</ul>يتضمن هذا المستودع نموذج VAE مضبوط بدقة من <a href="https://huggingface.co/stabilityai/stable-audio-open-1.0/" target="_blank" rel="noopener noreferrer">Stable Audio Open</a>، ومرخص بموجب <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/./third_party/LICENSE_StabilityAI.md" target="_blank" rel="noopener noreferrer">ترخيص مجتمع Stability AI</a>.

<strong>الاستخدام التجاري وإعادة التوزيع يتطلبان إذنًا مسبقًا من Stability AI.</strong></p><ul><li>📘 <strong>جميع الكودات والنماذج الأخرى</strong> تم إصدارها بموجب ترخيص أباتشي 2.0.</li></p><p></ul>---</p><h2>الشكر والتقدير</h2></p><p>شكراً جزيلاً لـ:</p><ul><li><strong>stable-audio-tools</strong> (من قبل Stability AI):</li>

</ul>لتوفير إطار عمل سهل الاستخدام لتوليد الصوت، بالإضافة إلى وحدة VAE والأوزان.

<ul><li><strong>MMAudio</strong>:</li>

</ul>لتنفيذ العمود الفقري MM-DiT في مجال الصوت.</p><hr></p><h2>📖 الاقتباس</h2></p><p>إذا وجدت ThinkSound مفيداً في بحثك أو عملك، يرجى اقتباس ورقتنا:</p><pre><code class="language-bibtex">@misc{liu2025thinksoundchainofthoughtreasoningmultimodal,

title={ThinkSound: Chain-of-Thought Reasoning in Multimodal Large Language Models for Audio Generation and Editing},

author={Huadai Liu and Jialei Wang and Kaicheng Luo and Wen Wang and Qian Chen and Zhou Zhao and Wei Xue},

year={2025},

eprint={2506.21448},

archivePrefix={arXiv},

primaryClass={eess.AS},

url={https://arxiv.org/abs/2506.21448},

}</code></pre></p><hr></p><h2>📬 Contact</h2></p><p>

✨ Feel free to <a href="https://github.com/liuhuadai/ThinkSound/issues" target="_blank" rel="noopener noreferrer">open an issue</a> or contact us via email (<a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/mailto:liuhuadai@zju.edu.cn" target="_blank" rel="noopener noreferrer">liuhuadai@zju.edu.cn</a>) if you have any questions or suggestions!</p><p>

---

Tranlated By <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">Open Ai Tx</a> | Last indexed: 2026-01-07

---</p>

</div>

<div class="original-link">

<strong>Original README:</strong> <a href="https://raw.githubusercontent.com/FunAudioLLM/ThinkSound/master/README.md" target="_blank" rel="noopener noreferrer">View on GitHub</a>

</div>

</div>

<div class="footer">

<p>Translated by <a href="https://github.com/OpenAiTx/OpenAiTx" target="_blank" rel="noopener noreferrer">OpenAiTx</a> |

Last updated: 2026-01-07

</div>

</body>

</html>